Прошлый «Фильтры поисковых систем 2018».

В этот раз я спросила мнение известных SEO-экспертов Рунета на очень актуальную тему — «Google vs. Яндекс: нюансы SEO под каждую из поисковых систем».

От себя хочу сказать еще такой важный момент — проверяя позиции, не забывайте смотреть релевантные страницы. Это одна из самых частых ошибок — когда в Гугле и Яндексе разная релевантная страница. То есть, вы уверены у себя в голове, что продвигаете главную, а в поисковой выдаче стоит вообще какая-нибудь карточка товара.

В разных ПС также может быть и разный ТОП — страницы немного разного типа. Хотя по опыту, чаще всего ТОП идет более-менее одинаковый. Опять же низкие позиции в поисковых системах часто бывают потому, что

А может вести себя как-нибудь не очень предсказуемо — вроде все хорошо, а в одной ПС стоит хорошо, в другой плохо.

Этим я обычно и занимаюсь во время своих больших аудитов — тщательно проверяю, в чем может быть проблема.

10 известных SEO-экспертов Рунета дали очень много интересных практических деталей, поэтому читайте внимательно, там много полезного!

Смотрите ниже следующие ответы:

1. Сергей Кокшаров (Девака)

2. Дмитрий Севальнев

3. Артур Латыпов

4. Михаил Шакин

5. Александр Алаев (АлаичЪ)

6. Денис Нарижный

7. Игорь Рудник

8. Алексей Трудов

9. Дмитрий Шахов

10. Dr. Max

Сергей Кокшаров,

SEO-аналитик, автор блога devaka.ru

Дмитрий Севальнев,

евангелист https://tools.pixelplus.ru/news/kommertsializatsiya) а в Google — показатель низкий.

В этом случае, не исключено, что и целевые URL могут отличаться. Случай экзотический, но реальный.

Особое внимание на переколдовку (расширение) запроса.

3. Для Google — больше точных вхождений, больше сами объемы текстов.

При этом, не забываем про Баден-Баден и прочие текстовые пост-фильтры Яндекса —

7. Важный технический аспект. Google воспроизводит JavaScript на странице и существенно понижает значимость текста, который можно скрыть с его использованием.

В случае, если используются подобные техники для вёрстки текста — важно учесть.

8. Работа с кликовыми ПФ. В Google meta-тег Description активно используются для сниппета, необходимо использовать это.

9. Отличается индекс и его полнота. Если документ проиндексирован в Яндексе, это не значит, что он в базе Google и наоборот. Надо проверять. Аналогично и со ссылочными донорами.

10. Важно установить Google Analytics для корректного учёта внутрисайтовых ПФ.

Общий вывод. Различия в позициях одного и того же сайта в двух поисковых системах, как правило, носят индивидуальных характер. Тем не менее, наиболее частые причины (в порядке убывания вероятности):

• региональность выдачи Google

• наличие санкций в одной из поисковых систем

• ссылочные факторы

• поведенческие факторы (GA и Метрика)

• текстовые (морфология)

Артур Латыпов,

руководитель рекламного агентства SEO Интеллект

Михаил Шакин,

shakin.ru

Александр Алаев (АлаичЪ),

Генеральный директор студии «АлаичЪ и Ко», автор SEO-блога АлаичЪ’а

проверял с закупкой чересчур большого количества ссылок, но получил проблемы только в Яндексе.

проверял с закупкой чересчур большого количества ссылок, но получил проблемы только в Яндексе.

По сравнению с Яндексом в Гугле санкций можно не опасаться. Ведь он по прежнему любит…

…Тексты и ссылки

Гугл любит тексты и ссылки. А еще старые сайты с историей.

Если в Яндексе молодой сайт имеет все шансы быстро попасть в топ и даже закрепиться там, то в Гугле этот путь заказан для слабых сайтов. Большие тексты рулят. Покупные ссылки рулят. Все то, за что в Яндексе проще получить санкции, чем добиться хоть какого-то роста.

К какому выводу мы невольно приходим – игнорировать требования Гугла, ориентируясь на Яндекс и надеяться, что в Гугле сайт тоже будет ранжироваться в регионе. В половине случаев все мероприятия направленные на улучшения в Яндексе срабатывают и в Гугле.

Большой опыт работы с сайтами под фильтром Баден-Баден и вывод из-под него показал, что Гугл все равно даже на такие действия. У сайта были хорошие позиции за счет seo-текста в категориях, например, после ББ это стало слишком и сайт «улетел». Для снятия фильтра удаляются все тексты, через месяц сайт восстанавливается в Яндексе, а Гуглу все равно – как был в топе, так и остался.

Как бы то ни было, в нашей работе мы всегда ориентируемся на Яндекс и наблюдаем за Гуглом.

Анализируя два топа можно увидеть, что состав сайтов в Яндексе и Гугле сильно разливается. Чуть больше года назад мы совместно с агрегатором Rookee.ru проводили исследование нескольких сотен тысяч запросов и сайтов в топе по этим запросам. В первую очередь изучали на предмет ссылочного влияния. Тогда мы смотрели последствия алгоритма Минусинск, и заметили четкую тенденцию, что в Яндексе в топе мало сайтов с большим ссылочным (и тренд дальше шел на уменьшение), в то время, как в Гугле топ занимают именно сайты с большим количеством ссылок.

Поведенческие и коммерческие факторы

Те самые факторы, которых в Гугле нет или они не учитываются. Удобство, юзабилити и прочие такие словечки, которые описывают доверие к сайту и удобство его использования, реально имеют эффект в Яндексе. Не удовлетворив коммерческим требованиям, невозможно рассчитывать на топ. Те самые вещи, которые заставляют владельца сайта повернуться к посетителю лицом, как минимум за это стоит держать курс на Яндекс.

В общем-то, никаких мифов и никакой магии – все предельно понятно и ясно, работаем на качество самого сайта, ориентируемся на пользователя и стараемся решить его проблему. Только в тот момент, когда мы сами становимся пользователями (хотим что-то купить или заказать) мы понимаем, насколько это важно, выбираем тот, сайт, где проще и понятнее совершить действие. Хочется, чтобы и веб-мастера/seo-специалисты обращали на это внимание, смотрели глазами пользователя. Поисковики за это наградят сторицей.

Сказал, как проповедник из стана сотрудников поисковой системы, но я правда так считаю, и своих ребят учу таким принципам.

Спасибо за внимание.

Денис Нарижный,

Head of SEO Rem.City

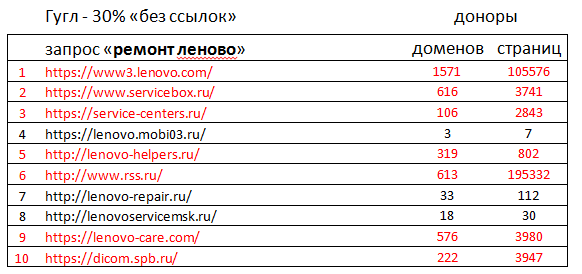

В таблицах красным отмечены сайты, ссылочные профили которых ощутимо меньше среднего значения количества доменов-доноров по топу.

— Среднее количество доменов на 1 сайт из топ в Яндекс равно 165 шт.

— Среднее количество доменов на 1 сайт из топ в Гугл равно 408 шт.

Продвигать в Яндексе можно без ссылок, в Гугл это очень сложно.

2. Текстовые факторы.

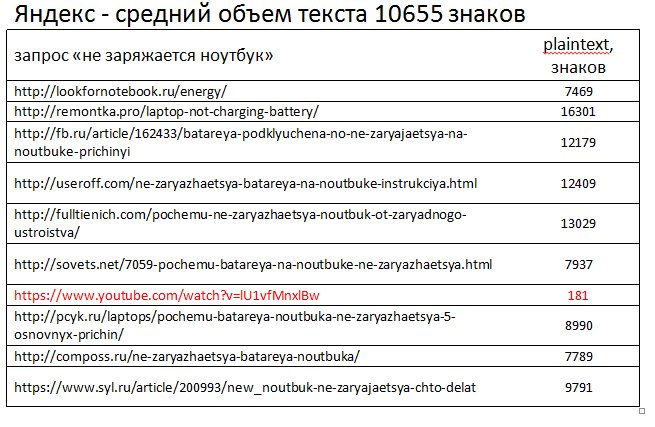

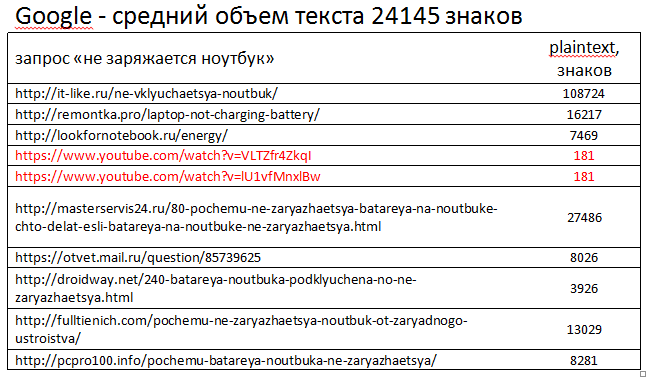

Следующее отличие касается тестов. Объем контента необходимый для занятия места в топе Гугла в среднем всегда выше, чем в Яндексе. А бывает, что в первой десятке Гугла находятся преимущественно лонгриды, а в Яндексе превалируют документы практически без текста. Для примера возьмем частотный запрос и посчитаем средний объем plaintext для первой десятки документов.

Расчет производился с помощью Majento TopAnalyzer. Примеси видео на youtube (в таблице помечены красным) для снижения погрешностей не учитывались.

3. Поведенческие факторы.

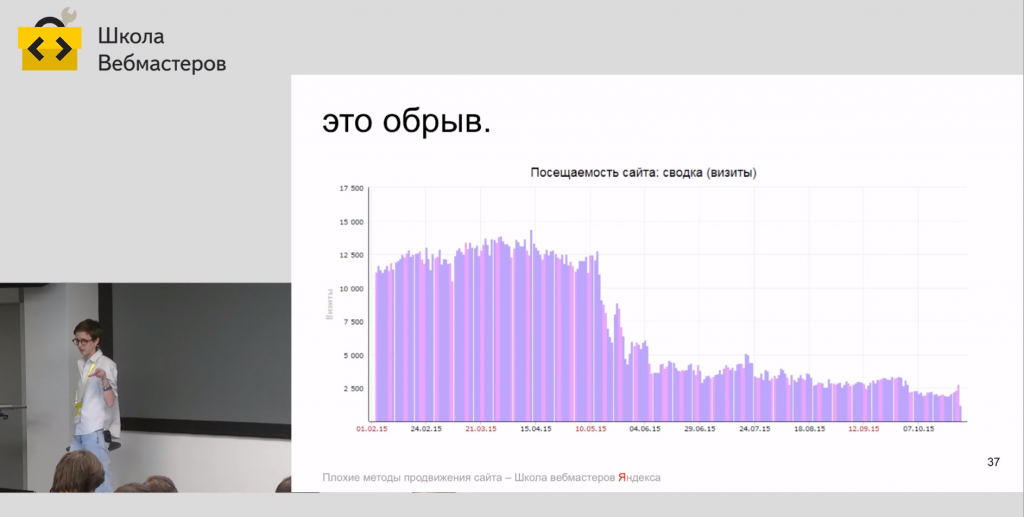

Манипуляции с пользовательскими сессиями на выдаче, жёстко караемые Яндексом на 8+ месяцев бана, Гуглом не признаются нарушениями. Отсутствие санкций за накрутки ПФ в Гугл обусловлено отсутствием официального признания поведенческих сигналов. В Гугл их влияние на итоговый вклад в ранжирование меньше, тем не менее тоже доказано экспериментально сеошниками из разных стран. Подробнее о накрутках в Яндекс смотрите тут: https://www.youtube.com/watch?v=UxrgaAjvAXw.

А так выглядит посещаемость сайта попавшего под бан за накрутки ПФ:

4. Коммерческие факторы.

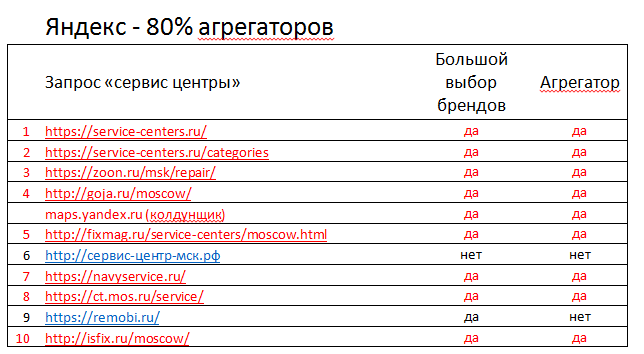

В коммерческих тематиках на ранжирование в Яндексе сильное влияет ассортимент. Привилегии в ранжировании сайтов с широким ассортиментом позволяют агрегаторам забивать топы, не пуская туда релевантные документы компаний с узкой специализацией. При этом в Гугл сайты неплохо ранжируются сайты с небольшим ассортиментом. Например, посмотрите на выдачи обоих поисковиков по запросу «сервисные центры».

Красным в таблицах отмечены агрегаторы предоставляющий большой выбор сервисных центров различных брендов. Гугл отдает предпочтение трастовым сайтам отдельных брендов, в то время как Яндексу дает пользователю сайты с широким ассортиментом брендов.

5. Гео факторы.

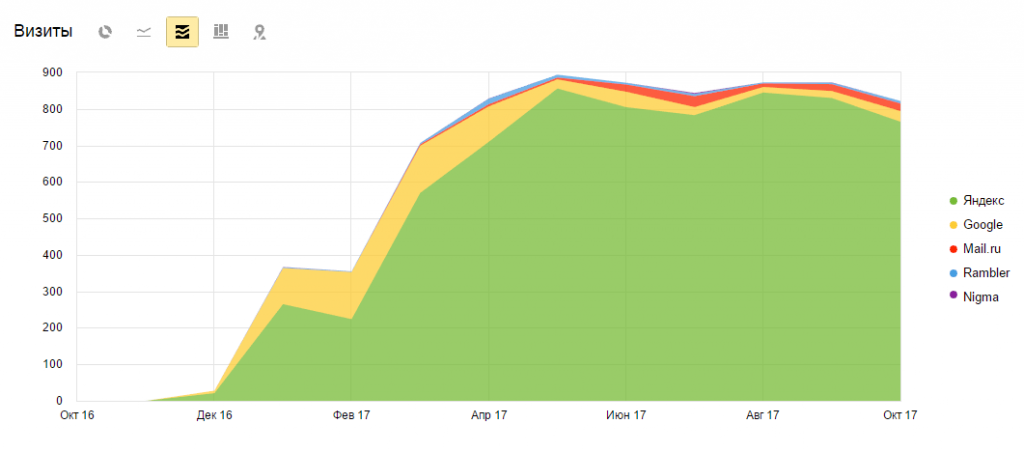

Ещё одно отличие, которое хотелось бы отметить, это работа с геозависимыми (ГЗ) запросами. Трюк с поддоменами, который можно провернуть в Яндексе, клонировав основной сайт и немного поработав с вхождениями топонимов, позволяет получать локационный трафик в другом регионе, а в Гугл этот прием не работает. Вот так выглядит трафик на региональных поддоменах:

Мы проверяли на очень приличных выборках из тысяч сайтов – в Яндексе Топы, в Гугл Ж*пы.

Игорь Рудник,

fb.com/irudnyk, руководитель сервиса крауд-маркетинг referr.ru и агентства семантического проектирования seoenergy.org

Проект №2

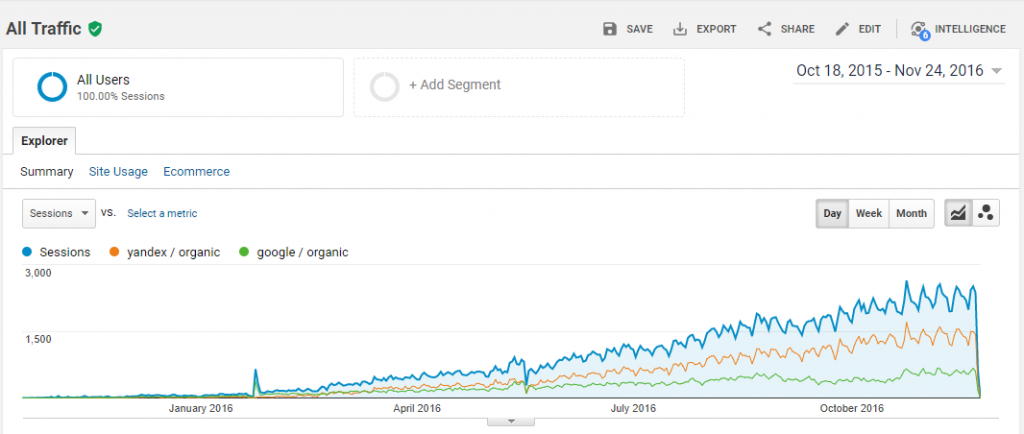

Контентный проект, на котором было размещено около 100 качественных статей, написанных медиком, с большим количеством фото и отличной структурой.

В результате Яндекс рос значительно быстрее, чем Гугл.

Google любит трастовые сайты, статьи нужно обязательно подкреплять ссылочным профилем. Без ссылок очень тяжело получить приемлемый результат.

Алексей Трудов,

SEO-аналитик, автор блога alexeytrudov.com, основатель сервиса bez-bubna.com

мое исследование влияния возраста в докладе для BDD).

мое исследование влияния возраста в докладе для BDD).

● Может по-разному оцениваться преобладающий интент запроса, ТОПы зачастую сильно отличаются не только по набору доменов, но и по типам контента. Например, в Яндексе — статьи, в Google — продающие коммерческие страницы. Впрочем, это не общее правило, зависит от тематики.

● Google хуже справляется с русской морфологией. Яндексоиды даже немного подкололи конкурента в одном из своих семинаров. Анализ русскоязычных текстов у Google менее продвинут.

● По Рунету у Яндекса гораздо четче геотаргетинг; при продвижении коммерческих сайтов с геозависимыми запросами необходимо с самого начала обеспечить правильную привязку к региону через Вебмастер, Каталог или Справочник.

● Как минимум до недавнего времени Google гораздо спокойнее относился к обилию прямых вхождений ключа. Но буквально месяц назад ситуация начала меняться, в сентябре был мощный апдейт алгоритма, множество переспамленных страниц ощутимо потеряли в трафике.

Хватает и других мелких различий (отношение к тегу alt изображений, длине title, nofollow-ссылкам, скрытому тексту, rel canonical). Они достаточно легко проверяются по выдаче.

Для практики я не советую заучивать эти или любые другие списки отличий. Факторов много, для разных запросов актуальны разные подходы к продвижению. Составить огромный чек-лист, чтобы последовательно его прорабатывать — плохая идея.

Ага, в гугле проблемы — докупим ссылок. Ой, не сработало. Значит понатыкаем побольше вхождений. Упс, у нас в гостях Минусинск, Баден-Баден и Fred.

Куда разумнее работать с конкретным проектом, его реальной статистикой и конкурентами. Смотрим запросы, которые удалось продвинуть в одном поисковике и не удалось в другом. Изучаем ТОП по ним, ищем отличия наших посадочных страниц от лидеров. Сравниваем динамику посещаемости и позиций у разных url проекта, выявляем удачные документы и закрепляем успех на них. Меняем шаблон вывода контента на паре десятков url, отслеживаем результат. Определяем причины у резких просадок и всплесков трафика. Оцениваем разницу в ранжировании по срезам запросов (например, с вхождением “купить” или “в Москве”). И так далее и тому подобное.

Пара часов ковыряния с панелями вебмастеров и системами статистики даст бездну идей по изменениям на сайте, подскажет компромиссную стратегию для получения максимума трафика из обоих поисковиков. И на деле это проще, чем кажется.

Дмитрий Шахов,

основатель агентства REMARKA

Гугл — ссылки и вхождения, Яндекс — контент на раскрытие интента и коммерческие.

Dr.Max,

drmax.su. Автор учебников SEO-Монстр, SEO-Гуру.

В SEO 13 лет, Опыт работы с буржуями – 7 лет. Крупнейший буржуйский клиент – с годовым оборотом интернет портала в $800.000.000 в год. Работа в 98% под Гугл.

http://drmax.su/klyuchevye-slova-lsi-algoritm.html/). Все это окунает нас в сферу LSI копирайтинга и машинного обучения.

http://drmax.su/klyuchevye-slova-lsi-algoritm.html/). Все это окунает нас в сферу LSI копирайтинга и машинного обучения.

Кроме того, если товарищ ответственно подойдет к работе, создавая полезный контент, он обязательно сопряжет теорию и практику, приведет кучу ярких примеров . Это, непосредственно, скажется на длине контента. Он будет гораздо больше, чем простой текст.

Итак, из простого определения, что КОНТЕНТ ДОЛЖЕН БЫТЬ ПОЛЕЗНЫМ, автоматически вылезли его признаки: он должен быть интересен, уникален, насыщен профессиональными терминами, содержать теорию, практику и примеры, быть большим по объему.

При этом, в обратную сторону – это не работает. Если я напишу 40 000 слов про мутации генов, не обладая при этом профильным образованием и какими — то наработками в этой тематике, даже если я насыщу контент всякими терминами и прочими словоблудиями – ни один товарищ из целевой аудитории не воспримет его как полезный. Никакого профта от такого контента я не получу.

Теперь о ссылочном.

Ссылки будут работать еще долго. Но не все. В случае, как и с контентом, работают только полезные ссылки. Я не буду расписывать, почему это так, просто перечислю признаки хорошей ссылки.

1. Трафик на доноре.

2. Ссылка хорошо вписана в контент статьи — донора, раскрывая, дополняя и поясняя её.

3. Релевантность типа «документ-документ», а не обязательно «сайт-документ». Учитесь писать отличные статьи – прокладки, для размещения своих ссылок.

4. Донор не в ссылочных/статейных биржах. Здесь велик риск получить автоматом падение качества донора и ссылка может стать «ядовитой».

5. Статья снабжена мультимедиа

6. Анкор не спамный (в разрезе всего ссылочного профиля).

Никакие сторонние метрики для определения «качества» донора не нужны. Все эти метрики выдуманы и служат только для набивания карманов, выдумавших эти метрики и продающие подписки на чекалки сайтов на эти метрики. Тут яркий пример такого зомбирования – это MOZ с их показателем DA, без которого большинство западных сеошников не могут судить о качестве сайтов. А стоимость подписки на чекалку этого и иного «синтетического» показателя – посмотрите у них сами.

Аналогично, есть и русские изобретения, не столь дорогие и претенциозные, тот же CheckTrust. Это всего – навсего способ заработка, не самый худший, признаюсь. Ребята – молодцы. Ну а Гуглу – абсолютно наплевать на этот показатель. Он о нем ничего не знает и знать не хочет и на ранжирование этот показатель влиять не может. Есть ли корреляция с показателями качества Гугла, нет ли – никто не знает. А самое главное, это никому не интересно.

Единственная реальная метрика – это количество ключей в ТОПе у донора и отсюда – размер органического трафика. Это «оценку» выставляет сама поисковая система и мы не будем спорить с ней.

Кстати, этот подход сразу выявляет товарищей, не разбирающихся в оптимизации. Если при вас заговорят о всяких там трастах, DA, трастфлов и прочих ТИЦах с мертвыми пейджранками, применительно к оценке качества сайта – не обращайте внимания на таких товарищей и критически отнеситесь ко всем их россказням.

Теперь о RankBrain и сотне прочих работающих факторах ранжирования. Хотелось бы сразу отметить одну важную штуку. Сайт должен быть не только полезен пользователю, но и удобен для работы. Что сразу переводит нас в плоскость обсуждения UI/UX дизайна и вынуждает соблюдать массу требований, начиная с классических «трех кликов до нужного контента», расположении блоков на странице, адаптацией под мобильные, скорость отображения сайта и пр…

Каждое из этих требований будет обусловлено десятком взаимопереплетающихся факторами ранжирования.

Ну возьмем , например, CTR в органике. Чем он выше, тем больше товарищей придет на ваш сайт. Более того, повышая CTR на 3-4%, Гугл поднимет в выдаче на 1 позицию, что автоматом опять позволит нарастить трафик.

В свою очередь CTR зависит от яркости сниппета, который порождается как тайтлом и дескрипшеном, так и контентом, в зависимости от запроса в органике.

Есть десятки стандартных приемов, повышающих заметность сниппета, основанных как на психологии, так и на манипуляции техникой.

К примеру, стандартные сниппеты в Гугле – 2 строки, а я могу заставить Гугл для моих страниц формировать 4-х строчные сниппеты. Под этими 4 строками текста могу прикрутить «хлебные крошки» и оценку страницы (звездочки). Такой снипет будет очень «выпуклым» и заметным в выдаче. Это и есть технические манипуляции.

А есть психологические приемы. Все эти списки (100 приемов… 25 способов), крючки и завлекалки. Это тоже позволяет повысить CTR.

Однако, если пользователь, перейдя на страницу, не найдет того, что ему обещали в сниппете, то никакой конвертации посетителя не будет. И тут мы опять возвращаемся к полезности контента.

Для себя я пользуюсь такой техникой составления Титла – в нем должно быть 2 части. В первой говориться о чем эта страница, во второй – как она может помочь посетителю. Аналогично с дескрипшеном.

Можно привести сотни приемов и способов того, что сегодня хорошо и очень хорошо работает в Гугле. Как раз сейчас я заканчиваю книжку «SEO Монстр 2020», там в одном из разделов будут описаны эти нехитрые, но полезные и неочевидные приемы.

Возвращаясь к тому же CTR и психологическому приему списков, вы, например, знали, что целые числа в тайтле работают на 10-15% лучше, чем некруглые и что «100 приемов продвижения» в тайтле для посетителя будут привлекательней чем «112 приемов продвижения». Странно, да? Но это психология. И это работает.

В SEO все взаимосвязано. И любая манипуляция, которая будет полезна для конечного пользователя, будет положительно влиять как на позиции в органике, так и на трафик, конвертации и в конечном счете, прибыль.

В этом и заключается хитрость всего SEO. А все остальное – это всего-навсего техника и хитрые и не очень хитрые приемы оптимизации.

С чем согласны, с чем не согласны? Какой у вас опыт продвижения под Гугл и Яндекс? Пишите в комментариях ниже!