Смотрите также 2 прошлых больших экспертных опроса на темы:

1. «Разница в продвижении под Google и Яндекс»

В этот раз я задала 12-ти известным SEO-специалистам такие вопросы:

— Какие фильтры Яндекса и Google досаждали больше всего в этом году?

— Насколько успешно получается с ними бороться, какие меры принимали? В чем были самые большие сложности?

— Какие фильтры стали менее ощутимы?

— Есть какие-то ценные, актуальные советы читателям – по профилактике и выходу из-под санкций?

Смотрите ниже ответы:

1. Сергей Кокшаров (Девака)

2. Дмитрий Севальнев

3. Алексей Волков

4. Артур Латыпов

5. Михаил Шакин

6. Алексей Степанов (АлаичЪ и Ко)

7. Денис Нарижный

8. Игорь Рудник

9. Алексей Трудов

10. Дмитрий Шахов

11. Валентин Батрак

12. Dr. Max

Сергей Кокшаров,

SEO-аналитик, автор блога devaka.ru

Дмитрий Севальнев,

евангелист Наиболее частыми фильтрами, с которыми SEO-специалисты сталкиваются каждый день, всё так же остаются https://pixelplus.ru/samostoyatelno/stati/prodvizhenie-saytov/sanktsii-poiskovykh-sistem.html скорей имеют единичные проявления. Повышенная частота лишь у кликджекинга и назойливой / обманной / избыточной рекламы.

Если говорить о сложностях, то тут всё стандартно, главное — быстро и точно диагностировать проблему, верно определить причины и приняться за решение проблемы. В ряде случаев (с рекламой) удается вернуть видимость в срок до 7 дней.

Самые сложные кейсы связаны с внешним ссылочным и «Минусинском», тут, порой, снятие санкций занимает до 3-5 месяцев и много-много труда.

Грамотно диагностируйте проблемы, с помощью комплексной проверки на фильтры, это позволит ускорить возвращение позиций в ТОП. Удачи!

Алексей Волков,

генеральный директор агентства рационального маркетинга авторского курса по SEO.

Артур Латыпов,

руководитель рекламного агентства SEO Интеллект и веб студии «Студия F1»

Михаил Шакин,

shakin.ru

Алексей Степанов,

Руководитель seo-группы веб-студии «АлаичЪ и Ко»

в статье на нашем блоге. Плюс, мы всегда стараемся писать в первую очередь для людей. Такой подход дает успешный результат примерно в 80 случаях из 100.

Относительно часто сталкиваемся с аффилированием, но тут ситуации всегда индивидуальные, поэтому какого-то универсального решения нет. Не так давно я писал практический кейс по выводу сайта из под аффилиат-фильтра, где на примере конкретного сайта подробно разобрал ситуацию и сам процесс вывода из под фильтра. Если же говорить в целом — справляемся с этой бедой довольно успешно, кроме тех случаев, когда со стороны клиента есть ограничения, из-за которых мы не можем в полном объеме провести нужные нам работы.

За последний год дважды столкнулись с фильтром за взрослую тематику. Первый сайт предоставляет услуги лечения венерических заболеваний, второй — пластической хирургии интимных мест. И что странно — в обоих случаях тех.поддержка Яндекса подтвердила, что фильтр наложен ошибочно. Казалось бы, проблем нет — признали вину, значит исправят ситуацию, правильно же? А вот и нет, когда мы работали по первому сайту, то Платоны «кормили» нас обещаниями все исправить целых четыре(!) месяца. Но, как говорится — «воз и ныне там». Со вторым сайтом только начали работу, но помня первый случай решили параллельно применить более радикальные техники. Если все получится, то обязательно выложим кейс на эту тему в нашем блоге, пока же еще слишком рано о чем-то говорить.

Какие фильтры стали менее ощутимы?

Как уже писал выше — менее ощутимы стали санкции со стороны Google, ну, либо нам просто очень везет и они обходят нас стороной. В отношении Яндекса определенно менее ощутимы стали фильтры Минусинск и хостовый Баден-Баден — то ли их запускали только для того, чтобы образумить сеошников, то ли все сайты перестали нарушать. Так или иначе, но в последний год мы не встречали ни один сайт с этими фильтрами.

Есть какие-то ценные, актуальные советы читателям – по профилактике и выходу из-под санкций?

К сожалению, сжато не получится дать какие-то конкретные советы по профилактике и выходу из под санкций, но на мой взгляд самое важное — «знать врага в лицо», когда есть понимание за что накладываются санкции, то понимание как их не допустить придет автоматически.

Денис Нарижный,

автор сервиса AskUsers.ru

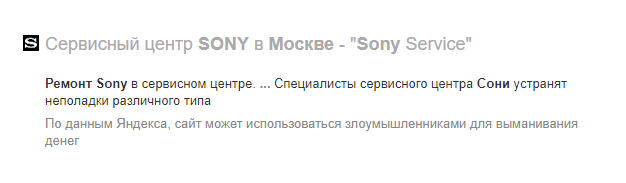

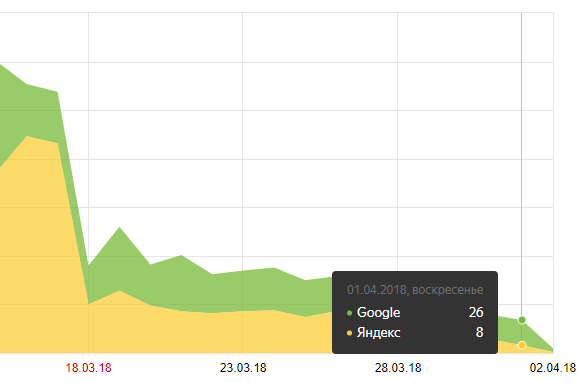

Какого либо понижения в позициях не было, сайты стояли на тех местах где и до появления надписи, просто резко просел трафик из Яндекса:

И тут мы ощутили всю весомость влияния поведенческих факторов — не прошло и недели как сайт плавно из ТОП3 перекачивал по всем запросам на вторую и третью страницу.

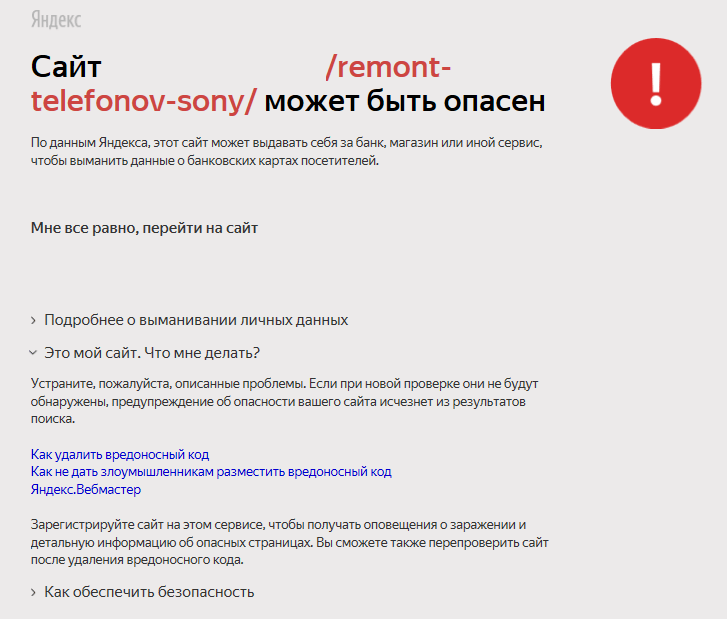

Попытки выяснить истинные причины появления подобных формулировок в сниппетах наших сайтов не увенчались успехом.

Да, Платон подтверждал отсутствие всех возможных причин соответствующих этой формулировке по соответствующей ссылке поисковика.

Да, у нас не было вредоносного кода, да, у нас не было даже онлайн оплаты, да, у нас был https и пользовательское соглашение на обычную форму обратного звонка, НО…

Но проблемы по мнению сотрудников Яндекса у сайтов имелись, и все наши попытки улучшать сайты не приводили к результатам. Решить проблему удалось только с помощью переезда сайта на новый домен.

Ручные санкции — это всегда более неприятная история, чем автоматические, которые можно снимать алгоритмически системно с помощью массы имеющихся на рынке инструментов, вплоть до автоматической разметки имеющихся на сайт ссылок на плохие (которые следует загнать в файл disavow для снятия ссылочных фильтров в Google) и хорошие специализированными сервисами. Но никогда не стоит отчаиваться, все вопросы решаемы, и частенько ручные санкции можно снимать переклейками и переездами на другие домены с полным или практически полным сохранением трафика и позиций.

Желаю всем не попадать под фильтры, много трафика и высоких конверсий!

Игорь Рудник fb.com/irudnyk, предприниматель.

Проекты: referr.ru — сервис крауд-маркетинга в СНГ и на запад, seoenergy.org — семантическое проектирование, new! Какие фильтры Яндекса и Гугла досаждали больше всего в этом году?

У Гугла за последний год никаких особо обновлений не произошло, со всеми его фильтрами уже научились работать.

У Яндекса фильтр «Малополезный контент, некорректную рекламу, спам» принес немного сюрпризов для контентных проектов. Пришлось разбираться.

Насколько успешно получается с ними бороться, какие меры принимали? В чем были самые большие сложности?

Самое болезненное в фильтрах — это размытость требований и диагностирование проблемы. Исправление — это, как раз, самый понятный и простой шаг.

В случае за «Малополезный контент, некорректную рекламу, спам» очень сложно понять, не понравились ли Яндексу какие-то отдельные статьи или же блоки рекламы, и что-то исправить можно только методом научного эксперимента.

В случае с вышеописанным фильтром, алгоритм следующий:

1. проверить рекламные блоки (особенно убрать блоки-ссылки);

2. сравнить количество и расположение рекламных блоков с другими сайтами в нише;

3. при необходимости снимаем;

4. делаем аудит контента;

5. убираем, либо дописываем слабые статьи;

6. параллельно общаемся с Платоном и пытаемся получить наводки на истинную проблему.

После этих действий нужно лишь ждать, развивать сайт и продолжать общение с поддержкой.

Какие фильтры стали менее ощутимы?

Все, которым уже несколько лет, так как с ними уже есть понятные алгоритмы работы.

Есть какие-то ценные, актуальные советы читателям – по профилактике и выходу из-под санкций?

Самая лучшая рекомендация — делать все, чтобы не попасть под фильтры. Не нужно пытаться обмануть поисковую систему, нужно понять ее точку зрения и стараться соответствовать.

Например, всем известно, что излишнее количество анкорных ссылок подводит сайт под Гугл Пингвин и Минусинск. Есть 2 варианта поведения:

1. пытаться найти грань, когда поисковые системы наказывают сайт;

2. работать с безанкорными ссылками и небольшим процентном анкорных, который точно безопасен.

Каждый выбирает свой путь, я больше склонен ко второму варианту. Он надежней.

Алексей Трудов,

Head of SEO в Legalbet, автор блога alexeytrudov.com, создатель сервиса глубокого анализа сайта bez-bubna.com

обзор на блоге). За прошедшее время появились и успешные кейсы по восстановлению трафика. Основная сложность — в том, что практически всегда действовать нужно по нескольким направлениям, вкладывая значительные ресурсы. Везде потребовался комплексный подход для улучшения поведенческих факторов. Волшебной таблетки нет.

Некоторые направления работ:

● Снижение агрессивности монетизации с сохранением большей части дохода благодаря гибкому управлению рекламой (собираем статистику, какие рекламные блоки на каких страницах дают мало конверсий, убираем неэффективные и раздражающие пользователя), поиск баланса.

● Создание специального вовлекающего контента (не под поисковые запросы, а для привлечения внимания пользователя, стимулирования переходов внутри сайта).

● Выявление тем, недостаточно раскрытых в контенте, поиск запросов, которым соответствуют наихудшие ПФ — и соответствующие правки текста,

Другие фильтры Яндекса продолжают работать, но они особо не заметны. Насколько я знаю, давно не было массовых санкций за накрутку ПФ или волн Минусинска. Вряд ли потому, что отдел антиспама о них забыл. Скорее уж оптимизаторы стали осторожнее.

Заслуживает отдельного внимания документный Баден-Баден. Понижение в ранжировании за неестественный текст по-прежнему весьма распространено. При этом далеко не всегда Баден-Баден легко диагностировать.

Не стоит думать, что наказывают только за спам n-граммами и воду. Так, нередко под раздачу попадают тексты, в которых копирайтер попытался добросовестно охватить семантику, вставив все возможные вариации запроса. Показатели вроде индекса биграмм в порядке, потому что вариации разнообразны по составу слов, но текст все равно получается не «человеческим».

В Google за последнее время не припомню прямо массовых санкций. Апдейтов алгоритма было немало, но это скорее «перетряхивание» факторов, нежели целенаправленные фильтры. Некоторое исключение составляют тематики, связанные с YMYL («Your Money or Your Life»), в первую очередь медицина. В них выше требования к качеству контента; изменения алгоритма зачастую влияют особенно сильно.

Помимо стандартных рекомендаций в духе «делайте сайты для людей» и «не наглейте в пихании ключей на страницу» в плане профилактики проблем с Google советую следить за чистотой индекса. Не стоит пускать в поиск недостаточно качественные страницы («zombie pages»), они мешают получать трафик другим разделам сайта. О том, как их найти и обезвредить зомби-страницы, можно прочитать в моем руководстве по аудиту контента.

Дмитрий Шахов,

основатель агентства REMARKA

Какие фильтры Яндекса и Гугла досаждали больше всего в этом году?

Никакие. Мы стараемся обходиться в работе без них. Если, конечно, не считать фильтром переспам – это скорее рабочий момент, чем фильтр.

Насколько успешно получается с ними бороться, какие меры принимали? В чем были самые большие сложности?

С переспамом бороться и просто, и сложно. Просто – когда клиент приходит с очевидно спамными текстами. Тогда надо просто переписать их или убрать. Другое дело, когда ты настолько приблизился в своей работе к грани, когда еще немного и переспам, плюс ощутимо колеблется граница спамности по топу, в эти моменты бывает трудно нащупать тот самый момент, когда надо остановиться. Или наоборот, сколько вхождений снять, сколько воды отжать, сколько ссылок с анкорами убрать, чтобы позиции прибавили еще 2-3 пункта.

Какие фильтры стали менее ощутимы?

Обычно клиент приходит с каким-то фильтром, и мы его снимаем. Давно уже не видели клиентов с фильтром за накрутку ПФ. Да и Минусинск последний приходил тоже давненько. Вот с ББ были. И, конечно, в портфеле есть достаточно клиентов, где трафика по Гуглу не было никогда – там или Панда, или Пингвин, снять которые не получается. А вот новые проекты, которые залетели под эти фильтры, практически не попадаются. Владельцы научились не косячить, делая новые сайты.

Есть какие-то ценные, актуальные советы читателям – по профилактике и выходу из-под санкций?

Все просто. Делайте сайт сразу хорошо. Тогда и санкций не будет. Если не хватает бюджета на хорошие тексты – просто не ставьте их. Не делайте пустых страниц, которые планируете потом наполнить. Не используйте бесплатные широко распространенные шаблоны – сразу их уникализируйте. Не спамите анкорами ни во внутреннем ссылочном, ни во внешнем.

Если все-таки попали под хостовый фильтр – не переживайте. Работайте так, как будто его нет. И параллельно проводите мероприятия по устранению фильтра. А борьба с переспамом – это часть вашей обычной работы. Границы спамности постоянно гуляют в обе стороны. Так что поможет только регулярная проверка сервисами оценки средней спамности по топу и коррекция текстов и плотности анкоров в ссылочном по итогам этого анализа.

Валентин Батрак,

SEO-Аналитик в Rush Agency, руководитель направления Зарубежного SEO. Основатель SEO-курсов Rush Academy

Dr.Max,

Ведущий отечественный оптимизатор и аудитор сайтов. Работает с частными и крупнейшими мировыми компаниями. Ведущий SEO блога drmax.su. Автор более 20 книг по продвижению сайтов.

снижение доли Яндекса на рынке. Если в России это ПС сейчас занимает 40-45% и тренд постоянно нисходящий, то в Белоруссии – 25%-30%, в Казахстане 14%, а на Украине доля Яндекса стремится к нулю. То есть, если ориентироваться на русскоязычных посетителей в мировом масштабе, то Яндекс можно не рассматривать совсем. Однако, если ваши сайты связаны с региональным SEO и с Россией, то кое-какое внимание можно уделять и этой ПС. Итак, налицо стагнирование Яндекса как ПС. Также это усугубляется практически полной коммерциализацией первой страниц органической выдачи.

2. Технологическое отставание Яндекса от Google, минимум на 2-3 года. Постоянно наблюдаю эту игру в догонялки, когда давно внедренные у Google вещи, через несколько лет появляются у Яндекса и выдаются за какое –то ноу-хау. Навскидку – те же LSI стали использовать для оценки в Google в 2011 году, в Яндексе – в прошлом/позапрошлом.

3. Ни один из здравомыслящих оптимизаторов не будет делать ничего для продвижения в Яндексе, если это принесет ущерб позициям в Google. И наоборот. Если вы смогли занять достойные места в Google, с 80% вероятностью вы попадете в ТОПы Яндекса автоматически.

Итак, сегодня стоит рассматривать единственную ПС – Google. Однако, по поводу фильтров, как таковых, говорить сейчас некорректно. Все, так называемые фильтры, стали составной частью поисковой системы. В этом и отличие от классических фильтров – которые были надстройкой на алгоритмами и запускались эпизодически, выкашивая сайты с плохим SEO. Сейчас все это происходит налету. Некачественные сайты имеют меньше шансов даже пробиться в ТОПы. Если ранее по воплям в сообществе, узревшим просадку тысяч сайтов, можно было понять, что ПС выкатили какой-то новый фильтр, сейчас это сделать сложнее, ибо воздействие алгоритмов на плохие сайты равномерно размазано и осуществляется постоянно.

Так что, Аня, давай говорить не о фильтрах, а о значимых изменениях алгоритма поисковой системы.

Чтобы понять, какие изменения ядра ПС оказали наибольшее влияние, я подготовил небольшую ретроспективу произошедшего в Google за 2018 год.

Итак:

• Январь – произошло 2 обновления алгоритма Google, связанные с оценкой качества страниц

• Февраль – обновление по выводу изображений в Google (опять можно собирать трафик из Google картинок). Также было одно обновление алгоритма, связанное с качеством контента.

• Март — пять обновлений алгоритма, связанных с оценкой качества контента.

• Апрель — обновление, связанное с E-A-T (по сути, то же самое качество), далее несколько технических апдейтов и крупное обновление ядра алгоритма, опять-таки связанное с качеством контента.

• Май – три обновления алгоритма, связанных с качеством контента, и одно обновление, пессимизирующие некачественное ссылочное и PBN.

• Июнь – три обновления алгоритма, связанных с качеством, далее мощная волна ручного бана PBN сеток (выполнена асессорами), видимо связанная с недостаточно четко отработавшим майским алгоритмом автоматического бана PBN.

• Июль — начало перехода на Mobile First Index. В конце месяца – развертывание алгоритма, где скорость доступа к странице является фактором ранжирования. Кроме того, в течение месяца 3 изменения в алгоритме, напрямую связанные с качеством контента.

• Август – критическое обновление алгоритма, связанное с E-A-T для YMYL сайтов (по сути – пессимизация некачественных сайтов). Далее – продолжается перенос сайтов на Mobile First Index. После этого опять обновление алгоритма, касающееся качества фарма (медицинских) сайтов.

Следовательно, было два важнейших обновления ядра алгоритма Google – это развертывание фактора скорости и развертывание Mobile First Index. Как к этому подготовиться я тщательно расписывал в моей книге SEO Гуру 2018, которая была выпущена весной. Ряд материалов есть на сайте drmax.su.

Соответственно, сайты, не подготовившиеся к внедрению Mobile First Index проседают в мобильной выдаче (а это, на сегодняшний день – более 60% посетителей), но более-менее держатся в десктопной. С некоторым допущением это можно назвать воздействием фильтра.

Развертывание Mobile First Index пока еще продолжается, и еще не все сайты ощутили на себе его «благотворное» влияние. Кстати, сайты, изобилующие Java скриптами и/или Flash вставками, могут испытывать затруднения при переходе к Mobile First Index. Это доложил Джон Мюллер – специалист по качеству поиска Google. Из-за наличия такого контента Google может не перевести их на новое индексирование.

Третьим важнейшим трендом развития ПС Google стала борьба за качество контента. Это подтверждается десятками крупных и мелких изменений алгоритма, позволяющих улучшить качество выдачи. При этом работа над качеством органической выдачи ведется планомерно, в течении многих лет. Свидетельство этому — периодический выпуск руководств по оценке качества для асессоров. В июле этого года вышла уже четвертая (или пятая) версия, и каждый желающий технический аудит сайта (обязательная составляющая качества), проверьте мобильную версию сайта и готовность к переходу на Mobile First Index, наполняйте сайты качественным, экспертного уровня контентом, стройте ссылки по уму и забудьте о фильтрах.

Всех благ.

Пишите комментарии, задавайте вопросы экспертам!