Вы можете проверить сайты с Netpeak Spider совершенно бесплатно (есть бесплатная версия программы без ограничений по времени использования, количеству URL и кастомизации настроек), а если требуется платный доступ, можно взять софт со скидкой 25% (скидка действует на первую оплату)!

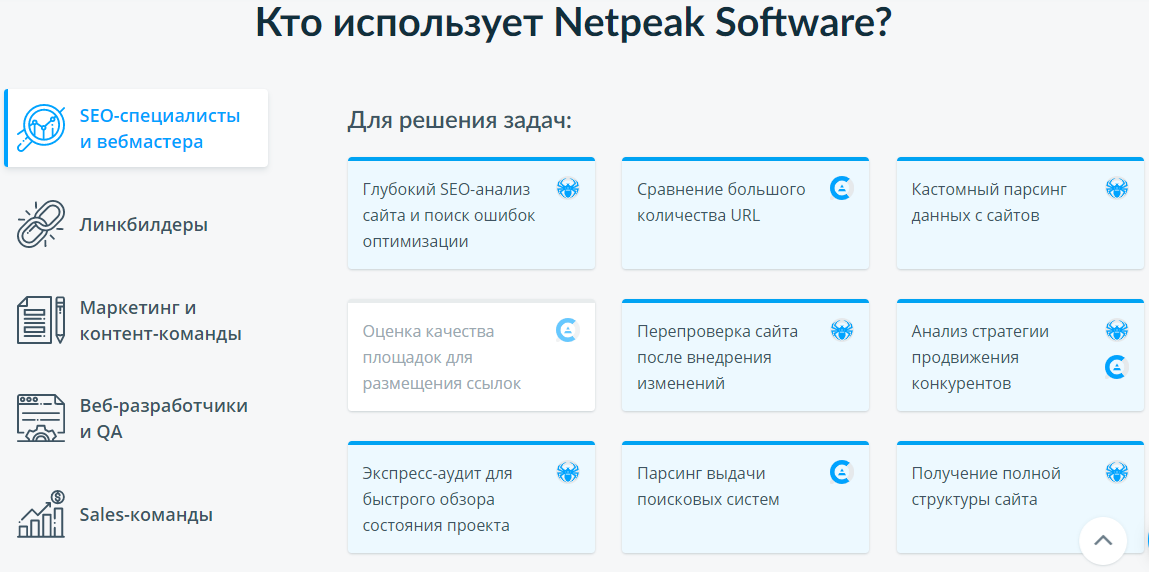

Компания Netpeak Software разрабатывает инструменты для SEO-специалистов и вебмастеров: Netpeak Spider (SEO-аудит, быстрый поиск ошибок, системный анализ и парсинг сайтов) и Netpeak Checker (парсинг поисковой выдачи и агрегация данных из топовых SEO-сервисов для массового анализа и сравнения сайтов).

Недавно в новом Netpeak Spider команда Netpeak Software внедрила функционал, которого не было ни у одного десктопного SEO-инструмента:

— интеграция с Яндекс.Метрикой;

— анализ hreflang;

— мультидоменное сканирование (в тарифе PRO).

С Netpeak Spider вы сможете провести глубокий SEO-аудит сайта, системный анализ и парсинг данных сайтов.

Если покупаете по моей ссылке, то получите Нетпик Спайдер со скидкой 10%.

Netpeak Spider — мощная десктопная программа для анализа сайта, которая в первую очередь предназначена для SEO-специалистов, так как основной её фокус направлен на поиск и выявление ошибок технической оптимизации.

Но, если хорошо изучить Нетпик Спайдер, то можно увидеть, что он справляется и с задачами другого рода, помогая специалистам других сфер: разработки, PPC, контент-маркетинга, продаж (об этом и сравнение с Screaming Frog SEO читайте в самом конце поста).

О возможностях софта Netpeak Spider будет подробно в этом посте.

В самом конце поста есть и промо-код на скидку 25% на первую покупку!

Но, если что, есть и пробная версия (банковской карты не надо). Можно скачать Netpeak Spider и пользоваться бесплатно.

То есть вы можете провести технический SEO-аудит сайта и воспользоваться другими возможностями программы прямо сейчас, по четким пошаговым инструкциям со скриншотами!

Еще можно скачать прямо здесь и посмотреть пример Экспресс-аудита в PDF на примере сайта opera.com

Самые-самые очевидные преимущества инструмента по сравнению с аналогами, кроме широкого функционала, это:

— высокая скорость (особенно хорошо ощущается для сайтов на 100К страниц)

— можно включать/отключать определённые параметры (в том же Screaming Frog SEO, например, нельзя). Об этом хорошо кратко в своем видео-отзыве на 2 минуты рассказывает Геннадий Сивашов (Evo: Prom). Говорит и о том, в чем именно удобство работы с Нетпик Спайдер на практике с многомиллионными проектами. Например, в том же Screaming Frog SEO ограничено количество экспортов, а в Netpeak Spider можно делать любое количество отчетов. Там же он отмечает другие моменты, которые ему понравились больше всего для крупных сайтов.

— хорошая, уникальная на рынке функция сегментации (в том же видео по ссылке выше Геннадий рассказывает и про неё).

— крутой экспресс-аудит в PDF — тоже, можно сказать, лучший на рынке. (пример аудита). Идеально для быстрого понимания и исправления ошибок.

— очень большая и продвинутая таблица — в ней множество функций, в отличие от опять того же Screaming Frog SEO, интуитивно с ней можно играться долго и очень разнообразно.

Начало работы с Netpeak Spider

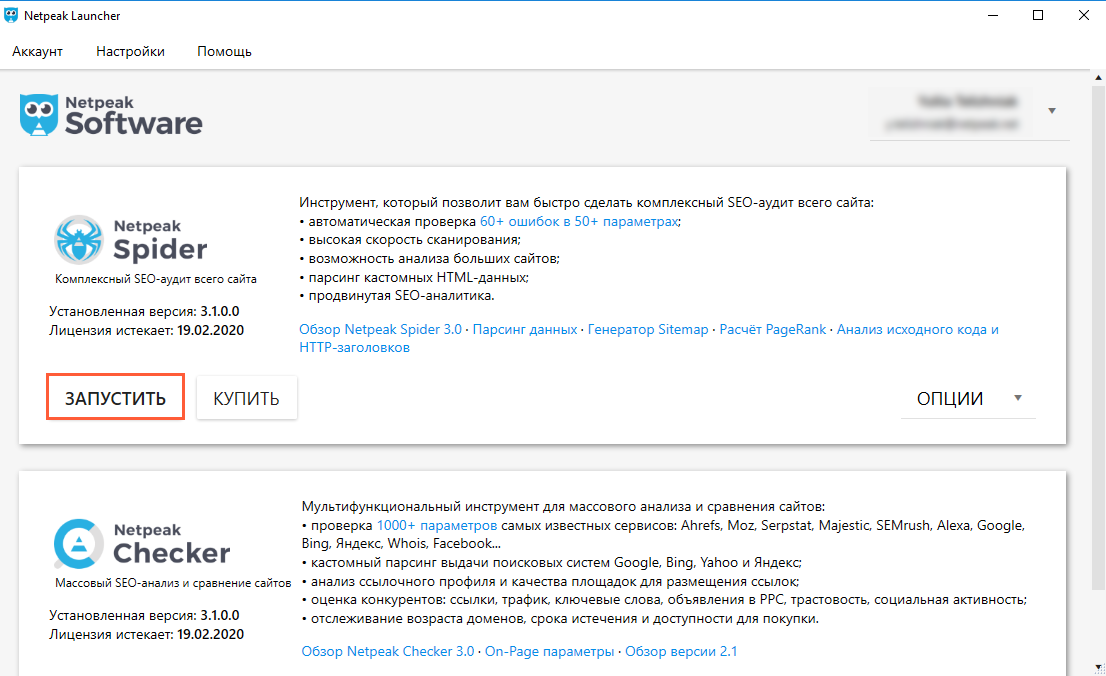

1. Заведите аккаунт на сайте Netpeak Software.

2. Скачайте и установите специальную программу управления продуктами, которая называется Netpeak Launcher. Затем выполните процесс авторизации и в ней же, скачайте и запустите краулер.

Начало работы и запуск сканирования

Основное окно

После открытия программы вы увидите основное окно, которое будет пустым, пока вы не начнёте сканирование.

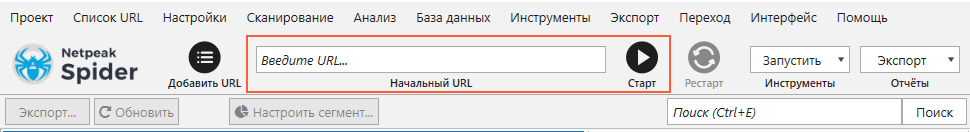

Чтобы просканировать сайт с настройками по умолчанию, нужно проделать два простых действия:

1. Вставить домен сайта в адресную строку.

2. Нажать кнопку «Старт».

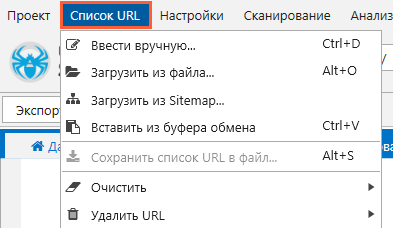

Сканировать можно и отдельный список URL: выберите, каким образом он попадёт в программу, с помощью меню с соответствующим названием.

Настройки

В настройках по умолчанию включены все необходимые опции, чтобы провести полный аудит сайта. Но при желании можно кастомизировать сканирование с помощью настроек. Все виды настроек в программе рассортированы по отдельным вкладкам:

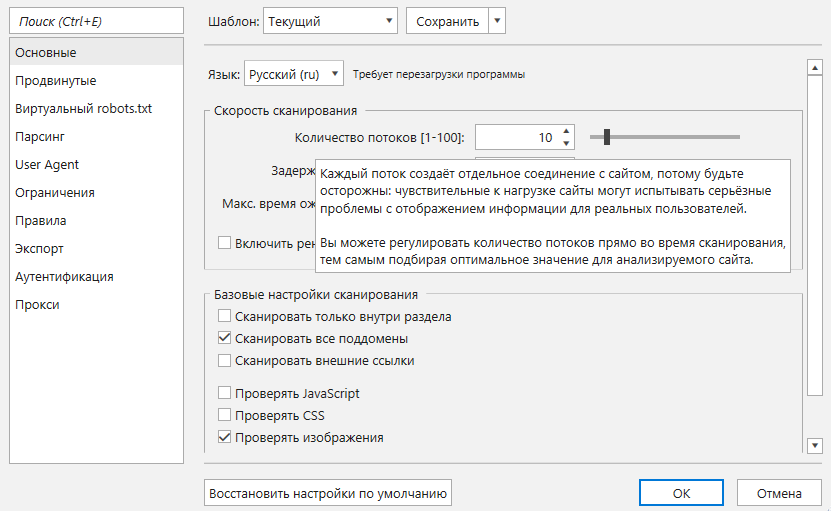

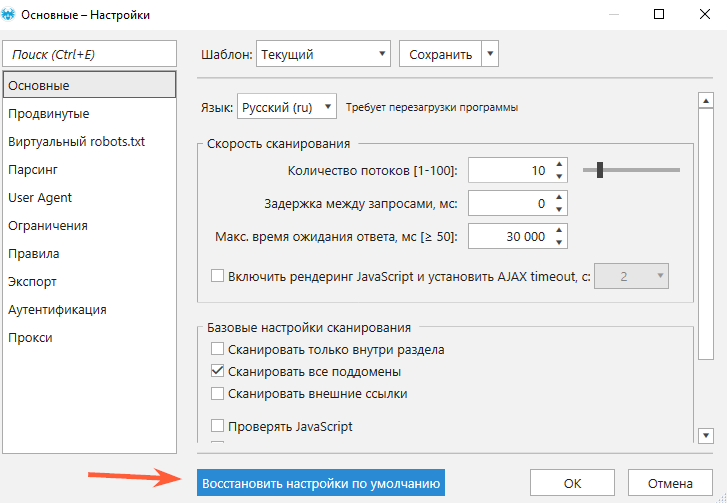

1. Основные. Базовые настройки сканирования, с помощью которых меняется язык программы, количество потоков и скорость сканирования и включается/отключается рендеринг JavaScript.

Если нужно более детально узнать, за что отвечает та или иная настройка, прочтите подсказки, которые всплывают при наведении курсора на название настройки.

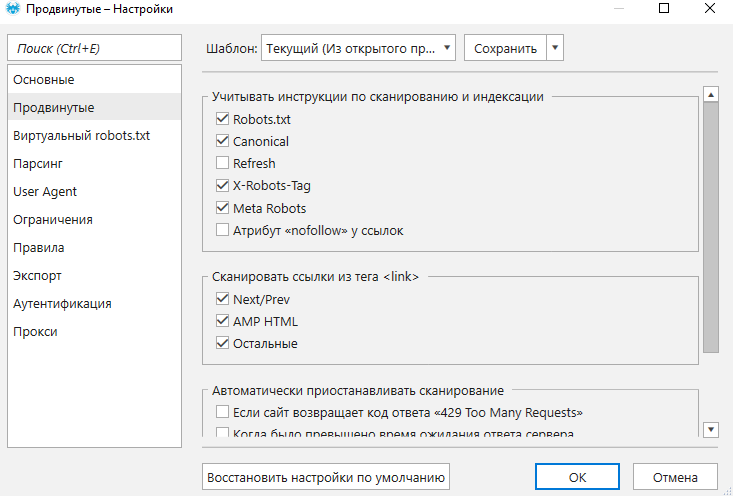

2. Продвинутые. Нужны для включения учёта инструкций по сканированию и индексации, а также для настройки автоматической приостановки сканирования, разрешения cookies, учёта страниц с 4xx ошибкой и относительных канонических URL.

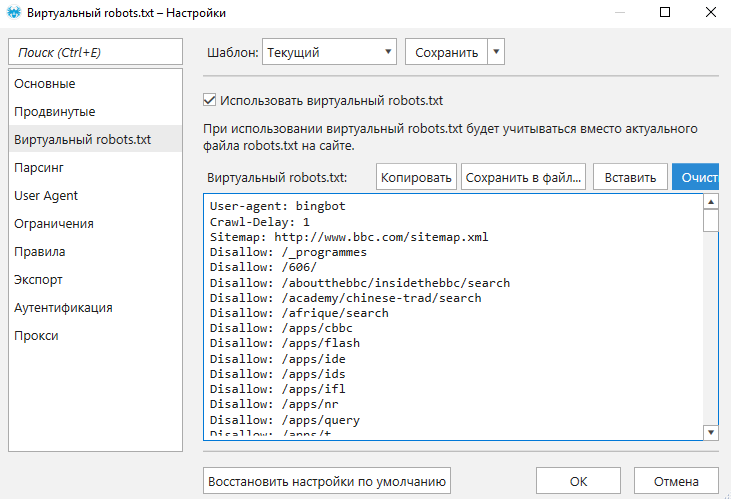

3. Виртуальный robots.txt. Полезная функция, когда нужно проверить обновленный или новый файл. Всё, что нужно сделать — это активировать функцию, вставить содержимое файла в окно и сохранить.

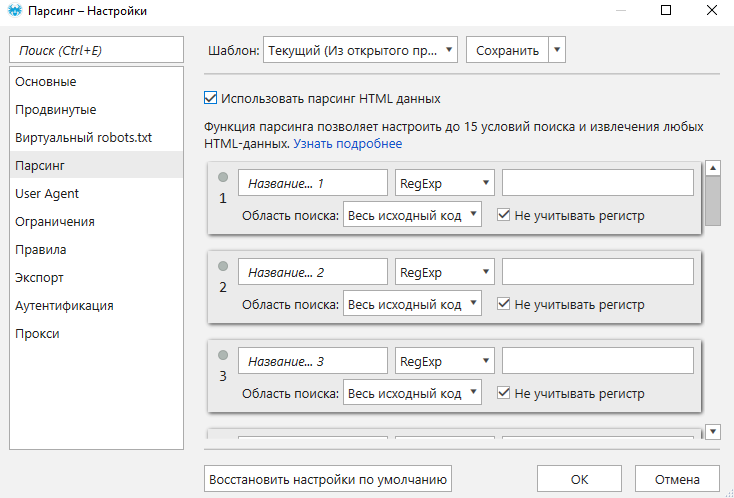

4. Парсинг. На этой вкладке задаются параметры и условия поиска для парсинга данных. Если вы хотите детально ознакомиться с парсингом в краулере и понять суть его работы, нажмите «Узнать подробнее». На этой вкладке, как и на предыдущей, предусмотрена кнопка включения и отключения настройки: с её помощью можно не учитывать настройки, при этом не удаляя внесённые вами данные.

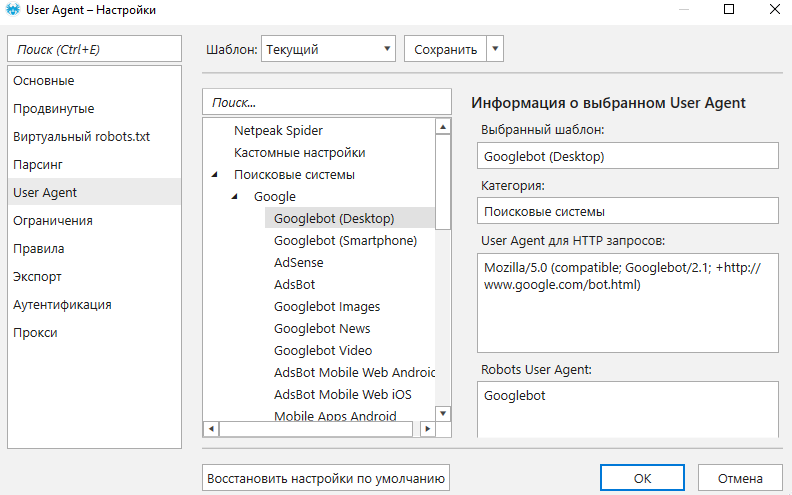

5. User Agent. Здесь можно выбрать поискового робота, браузер и устройство, через которые будет осуществляться соединение с сервером. Функция полезна, когда необходимо узнать, как различные ПС и браузеры «видят» сайт.

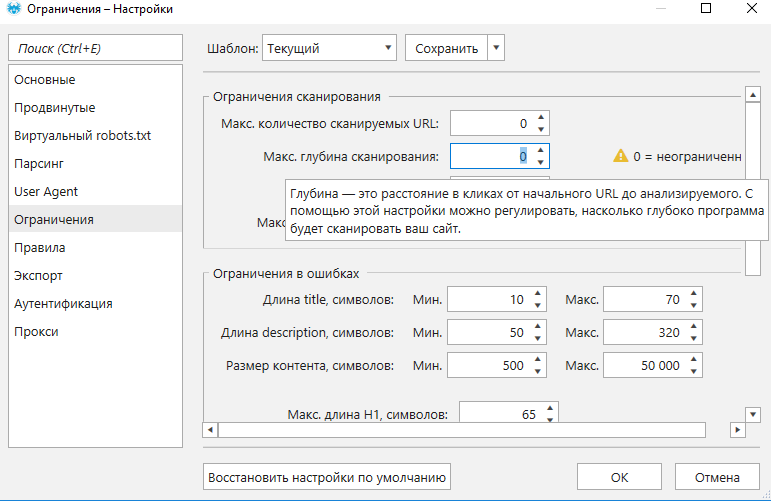

6. Ограничения. На этой вкладке вы можете вручную задать ограничения сканирования и учёта ошибок.

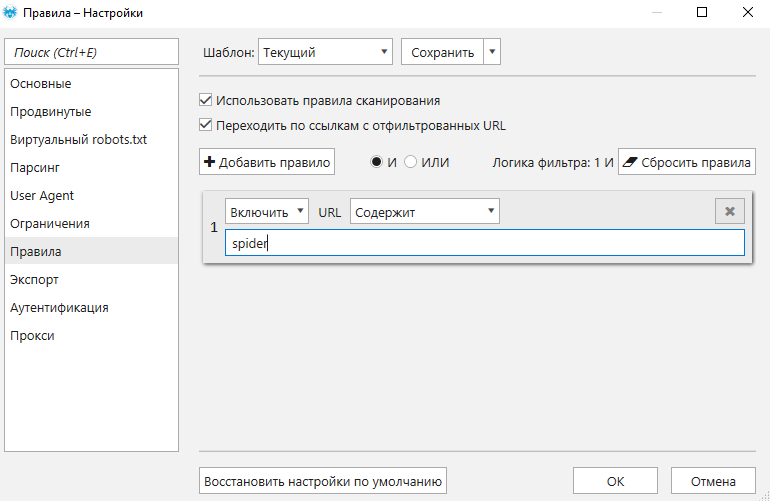

7. Правила. Правила позволяют включать или исключать различные типы URL при сканировании сайта. Это может пригодиться, например, когда нужно просканировать URL, которые содержат определённое слово/символ.

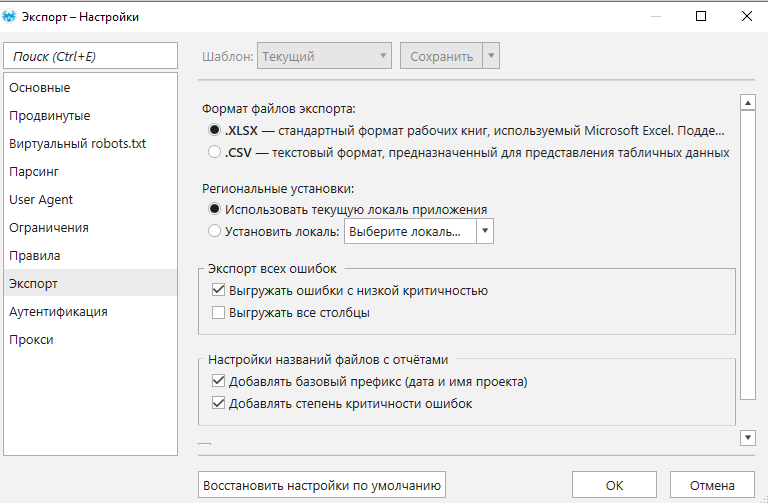

8. Экспорт. Здесь можно установить свои настройки для выгружаемых отчётов: от формата файла до выделения цветом ячеек.

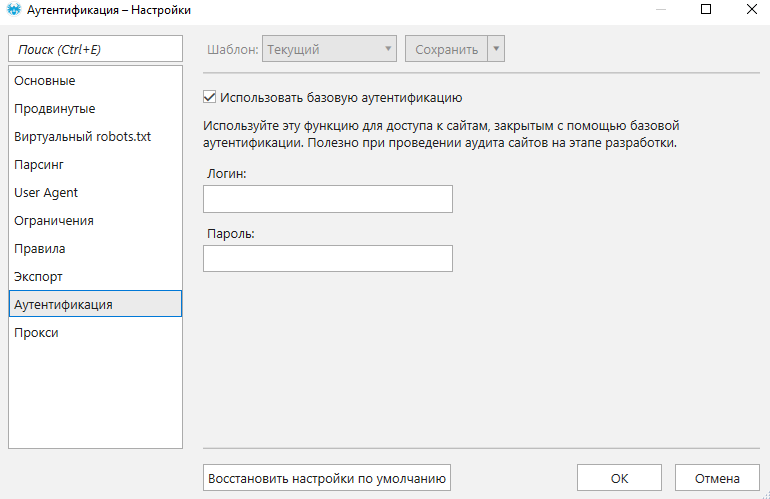

9. Аутентификация. Настройка позволяет сканировать закрытые с помощью базовой аутентификации сайты. Функция полезна тем, что с её помощью можно посмотреть технические параметры сайта на любом этапе разработки.

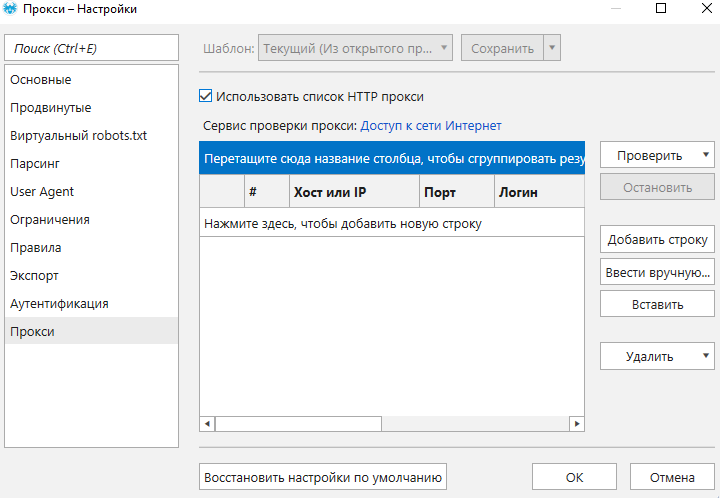

10. Прокси. Если вы используете прокси во время аудита, вставлять и проверять их нужно на этой вкладке.

Вернуть настройки к дефолтному виду можно в один клик — с помощью кнопки «Восстановить настройки по умолчанию», которая есть на каждой вкладке.

Параметры

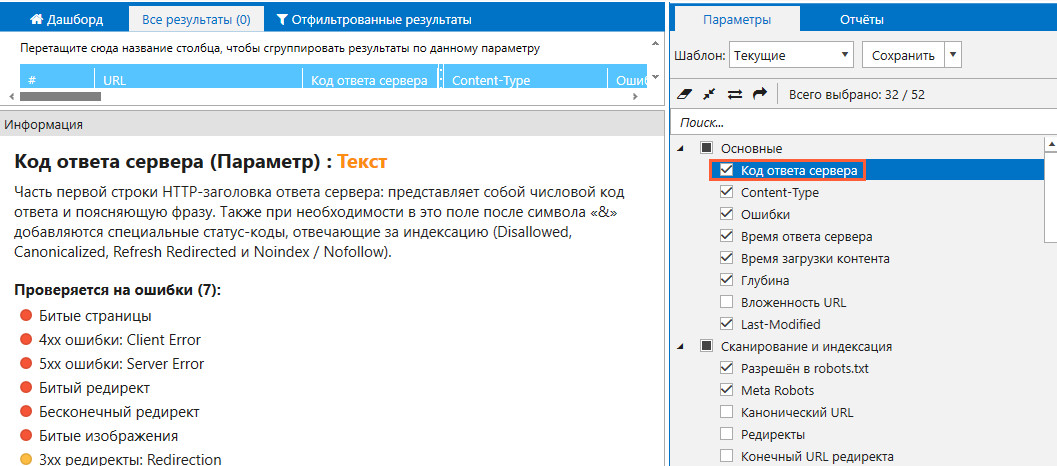

Кастомизировать сканирование позволяют также параметры, весь список которых представлен на боковой панели основного окна.

Всего параметров 54, и они рассортированы по отдельным группам:

— Основные.

— Парсинг.

— Индексация.

— Ссылки.

— Head теги.

— Контент.

Если вам нужно подробнее узнать о группе параметров и каждом в отдельности, нажмите на любой из параметров, и в поле «Информация» отобразится подробное описание.

На этой вкладке есть набор преднастроенных параметров, объединённых в шаблоны.

Всего их пять:

1. Текущий: тот, что вы выставили для открытого проекта.

2. Минимум: заточен под быстрый сбор всех страниц сайта и собирает информацию только о кодах ответа сервера, глубине и канонических URL.

3. По умолчанию (рекомендуемый): включает параметры, которые позволяют выполнить полноценный аудит сайта.

4. Для PageRank: параметры, которые нужны для расчёта внутреннего PageRank.

5. Все: включает все доступные параметры.

После запуска и окончания сканирования

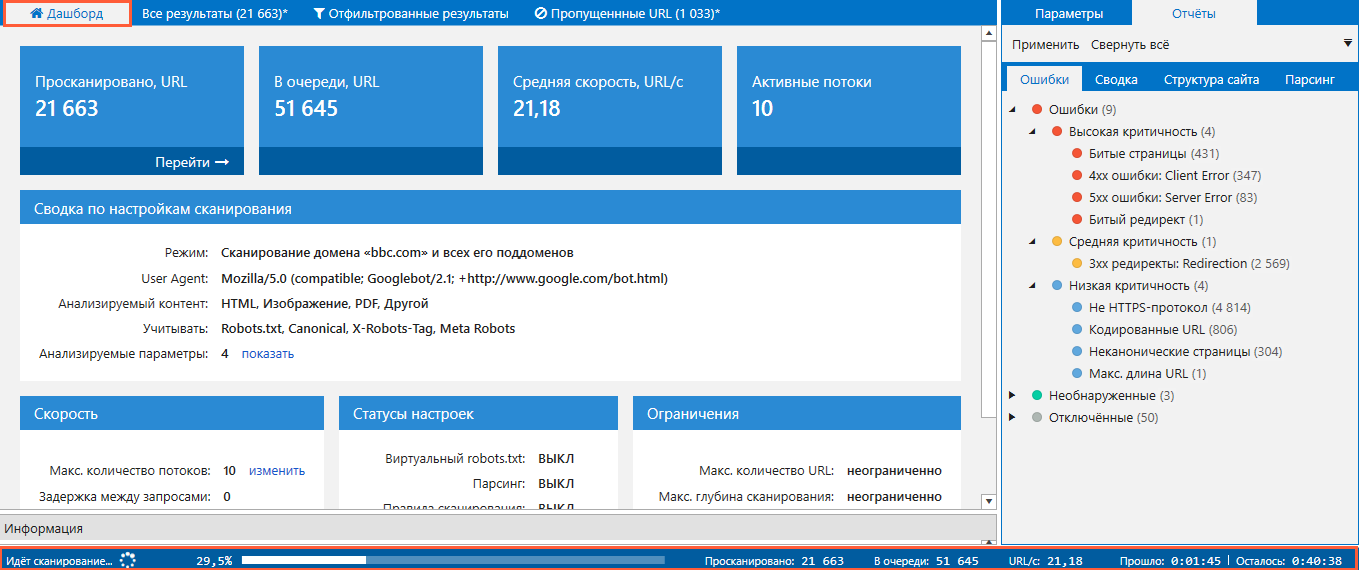

Итак, когда вы начали сканирование, за ним можно наблюдать онлайн: на адаптивном дашборде показаны данные о URL, скорости, настройках и ограничениях.

Если во время сканирования вам захотелось изменить настройки, нужно нажать на паузу, внести изменения и снова нажать «Старт»: в таком случае новые настройки будут распространяться на страницы, которые ещё не попали в результаты.

Чтобы перезапустить анализ по новой, после паузы нажмите на «Рестарт».

Если необходимо изменить потоки сканирования, это можно делать и без паузы: просто зайти в настройки, выставить нужное количество и нажать «OK».

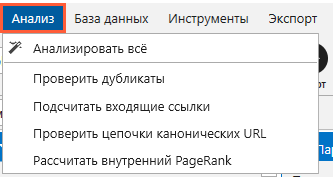

Анализ данных

По окончании сканирования программа начнёт выполнять анализ тяжелых данных: дубликатов, входящих ссылок, цепочек Canonical и внутреннего PageRank.

При желании его можно остановить кнопкой «Отмена».

И возобновить в любой момент через меню «Анализ».

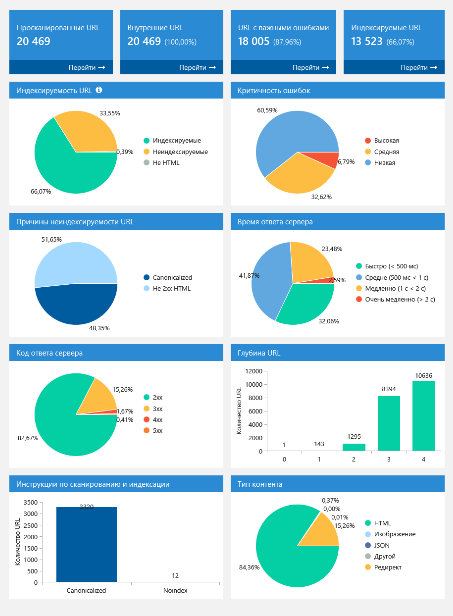

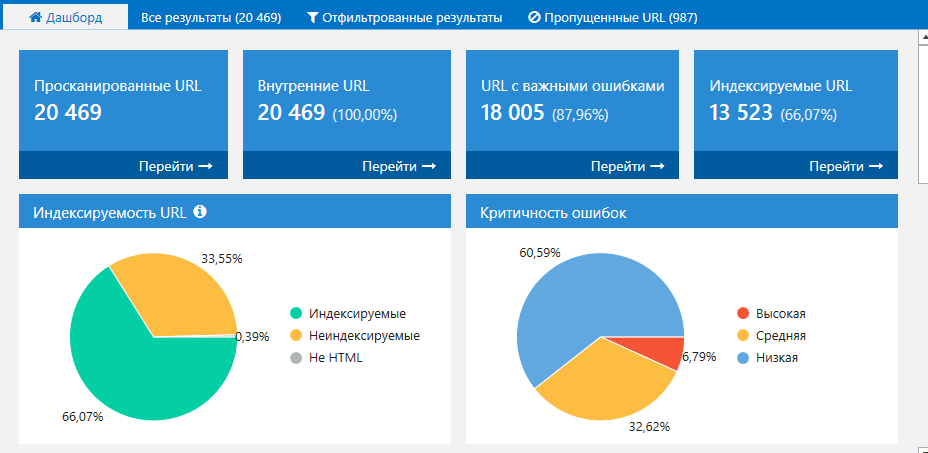

Дашборд после сканирования

Дашборд после окончания сканирования принимает иной вид: теперь на нём выводятся столбчатые и круговые диаграммы с полезными инсайтами об индексируемости, кодах ответа сервера, типах контента и других важных показателях.

Кстати, вы можете его сохранить в PNG-формате на компьютер, нажав кнопку «Экспорт».

Вот так он будет выглядеть:

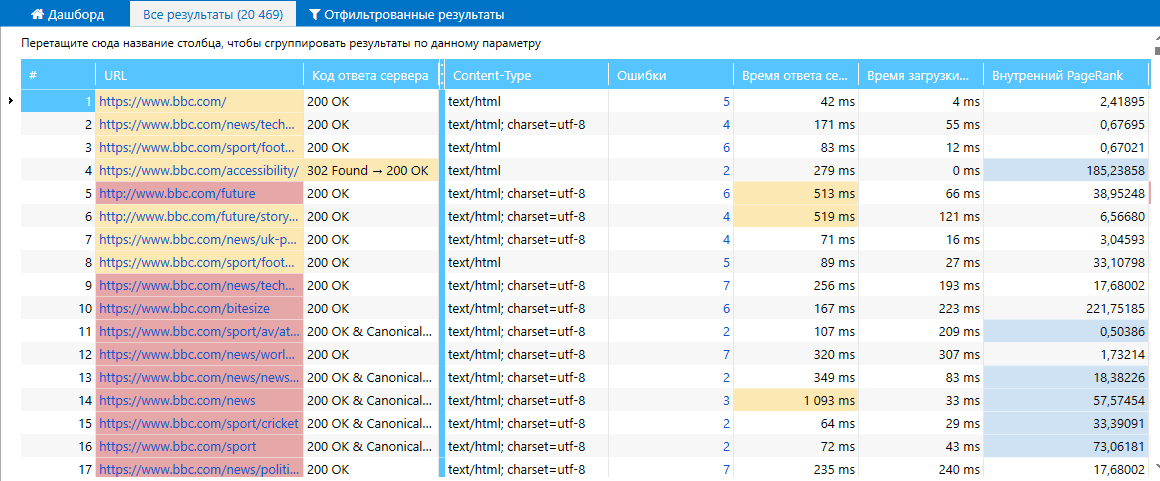

Вкладка «Все результаты»

Идём дальше знакомиться с результатами на соседнюю вкладку «Все результаты».

Здесь отображаются просканированные URL, а также параметры по каждому из них.

Цвет ячеек сообщает о критичности ошибок, которые присутствуют на странице:

красный — высокая;

жёлтый — средняя;

синий — низкая.

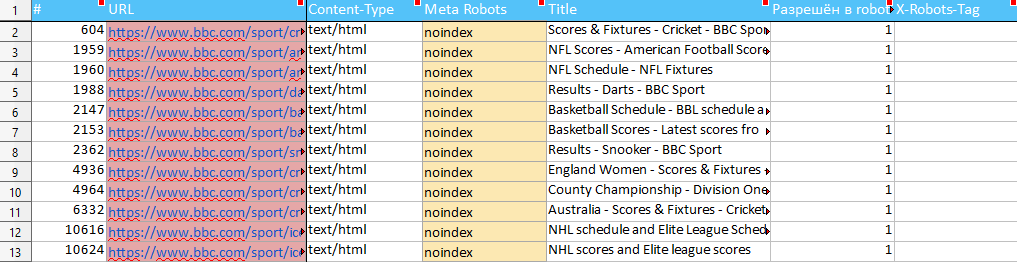

Обратите внимание на специальные статус-коды, отвечающие за индексацию: благодаря им прямо из колонки видно, закрыта или открыта страница для сканирования роботами.

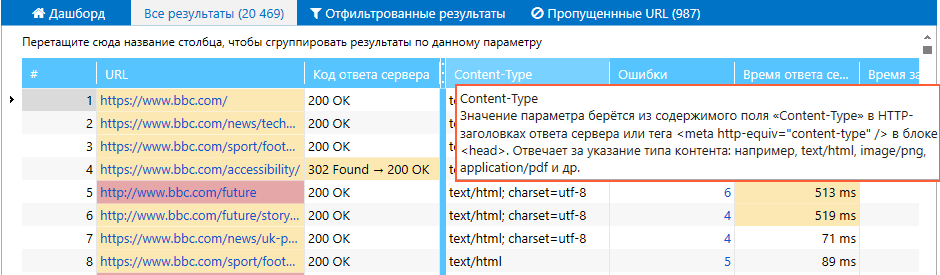

В таблице есть всплывающие подсказки для каждого параметра:

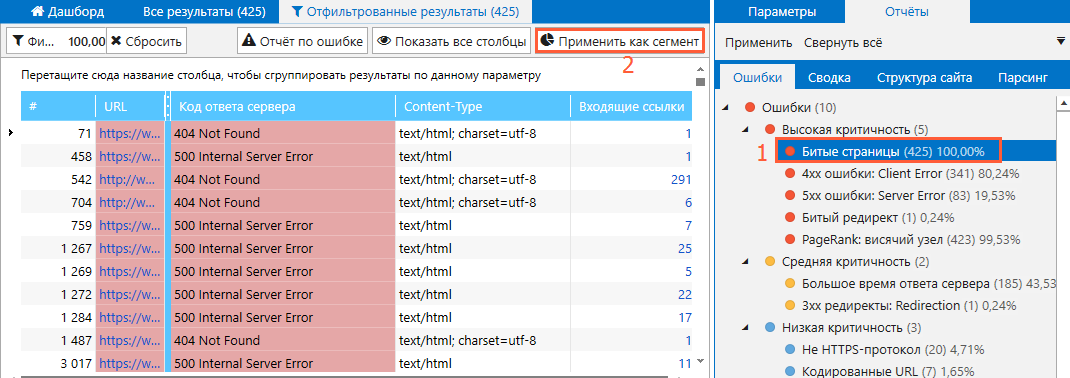

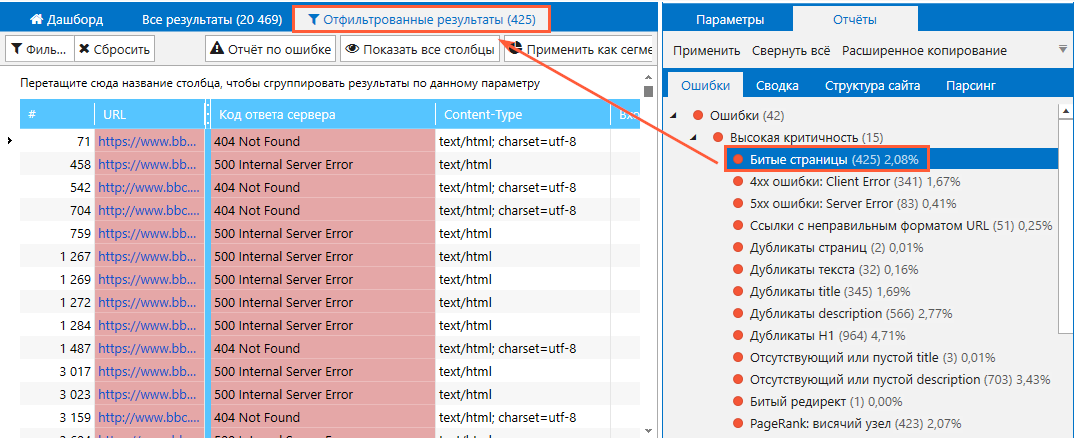

Вкладка «Отфильтрованные результаты»

Следующая вкладка — «Отфильтрованные результаты». Здесь содержатся отфильтрованные от всех результатов страницы по параметру или ошибке на боковой панели и вкладке «Дашборд». Чтобы отфильтровать страницы, просто кликните на любую ошибку на боковой панели:

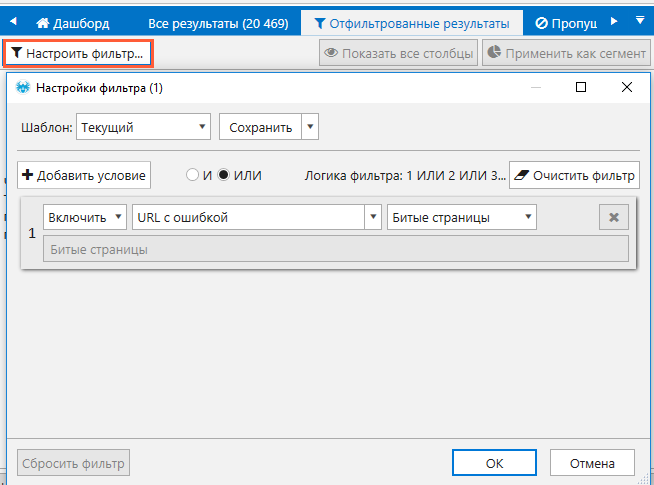

Фильтрацию также можно настроить самостоятельно: нажимаем кнопку «Настроить фильтр», добавляем условия и нажимаем «OK» → в таблицу попадут URL, соответствующие заданному фильтру.

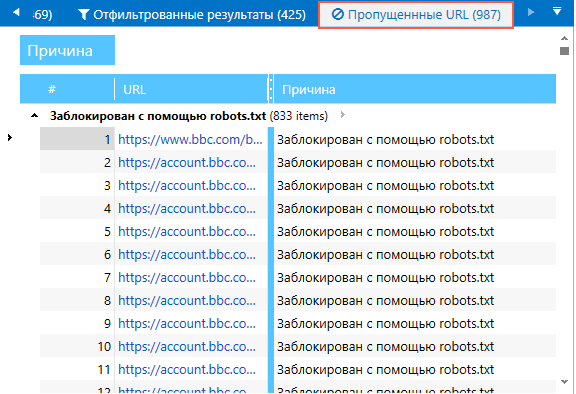

Вкладка «Пропущенные URL»

Если в ходе сканирования появилась вкладка «Пропущенные URL», значит на сайте есть страницы, которые краулер пропустил из-за соответствующих настроек сканирования. Причина несканируемости указывается в отдельном столбце.

Боковая панель

Далее двигаемся вправо и переходим на боковую панель: здесь содержатся важные отчёты по:

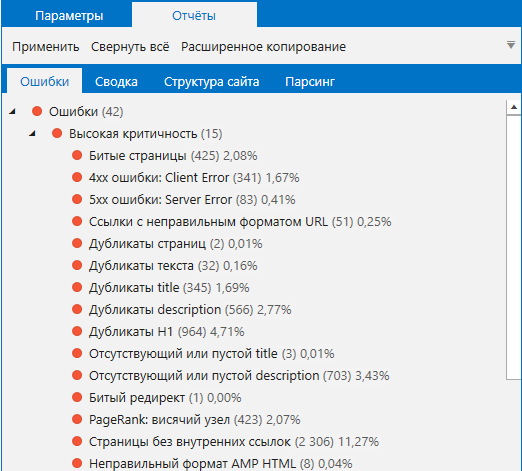

1. Ошибкам. В этом отчёте находятся все ошибки, которые были найдены во время сканирования. Включая информацию по Title, H1, Meta Description и другое. Ошибки, определяемые краулером, но которые не были найдены на сайте, находятся в отдельных разделах «Необнаруженные» и «Отключённые». Это сделано специально, чтобы вы смогли сначала обратить внимание и сфокусироваться на реально существующих данных.

2. Сводке. Это отчёт, сгруппированный по таким параметрам, как статус, тип страниц, протокол, хост, коды ответа сервера и др.

3. Структуре сайта. Это отчёт с выгрузкой полной структуры сайта, которая формируется на основе структуры просканируемых URL.

4. Парсингу. В этом отчёте находятся данные, которые были получены с помощью заданных условий парсинга.

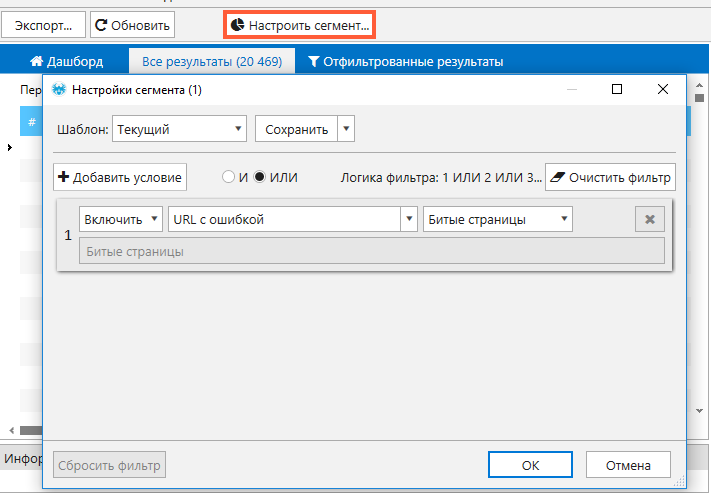

Сегментация

Для упрощения работы с массивными данными можно сегментировать конкретную выборку и проводить анализ строго по ней. В качестве сегмента применяются любые данные, которые можно отфильтровать. Также сегментация распространяется на инструменты «Расчёт внутреннего PageRank» и «Генератор Sitemap», о которых мы поговорим ниже.

Начать работу с сегментированием можно в таблице «Отфильтрованные результаты»:

1. Выберите любой параметр, по которым будут отсортированы URL.

2. Нажмите кнопку «Применить сегмент».

После применения сегмента, все отчёты будут отображаться только для тех страниц, которые были выбраны.

Второй способ позволяет настроить сегмент по заданным условиям: его настройка похожа на настройку фильтров и правил.

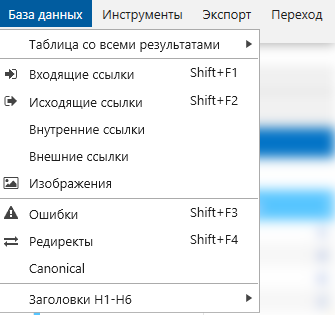

Модуль «База данных»

Далее мы поговорим о модуле «База данных», так как многим не сразу очевидны его функция и предназначение. В нём собраны отчёты по входящим и исходящим ссылкам, ошибкам, изображениям, редиректам, атрибутам Canonical, заголовкам, а также результатам парсинга.

Благодаря модулю экономятся ресурсы вашего устройства, так как все массивные данные хранятся на жёстком диске.

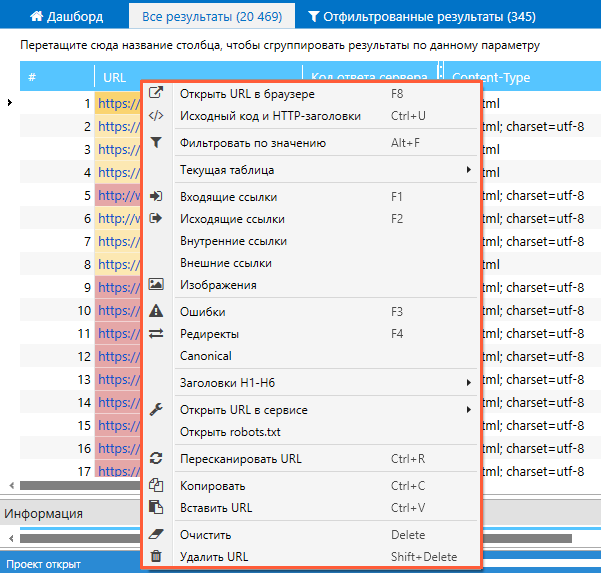

Контекстное меню

С помощью контекстного меню быстро выполняется ряд действий с URL, не покидая основное окно программы. Открывается оно, если кликнуть правой кнопкой мышки по любому URL.

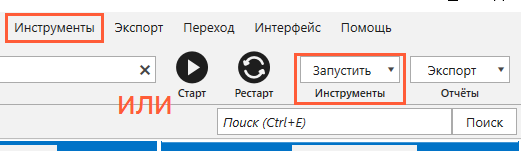

Встроенные инструменты

В Netpeak Spider есть 4 инструмента, которые «вшиты» в саму программу. Открываются они через меню «Инструменты» на верхней панели окна или в правом верхнем углу.

Теперь по порядку о каждом инструменте.

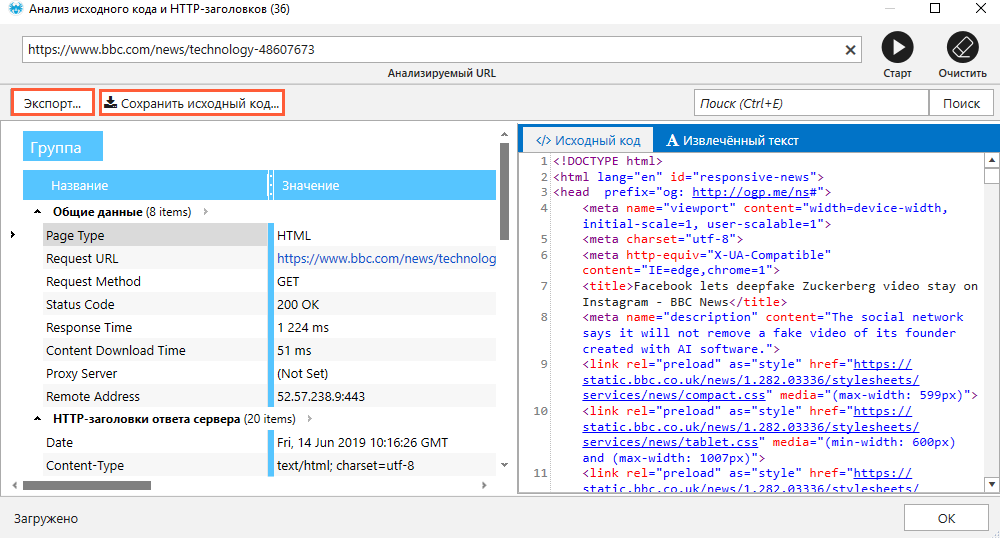

Анализ исходного кода и HTTP-заголовков

Он открывается с помощью меню «Инструменты» или с помощью того же контекстного меню. Инструмент проверяет исходный код страницы, сообщает данные о HTTP-заголовках запроса и ответа сервера и показывает список GET-параметров.

Особенно удобно использовать, когда нужно посмотреть исходный код страниц защищённых сайтов, тех, у которых отсутствует часть стандартного набора HTML-тегов, или же когда для разных IP отдаётся разный контент.

Данные из инструмента сохраняются и экспортируются с помощью соответствующих кнопок.

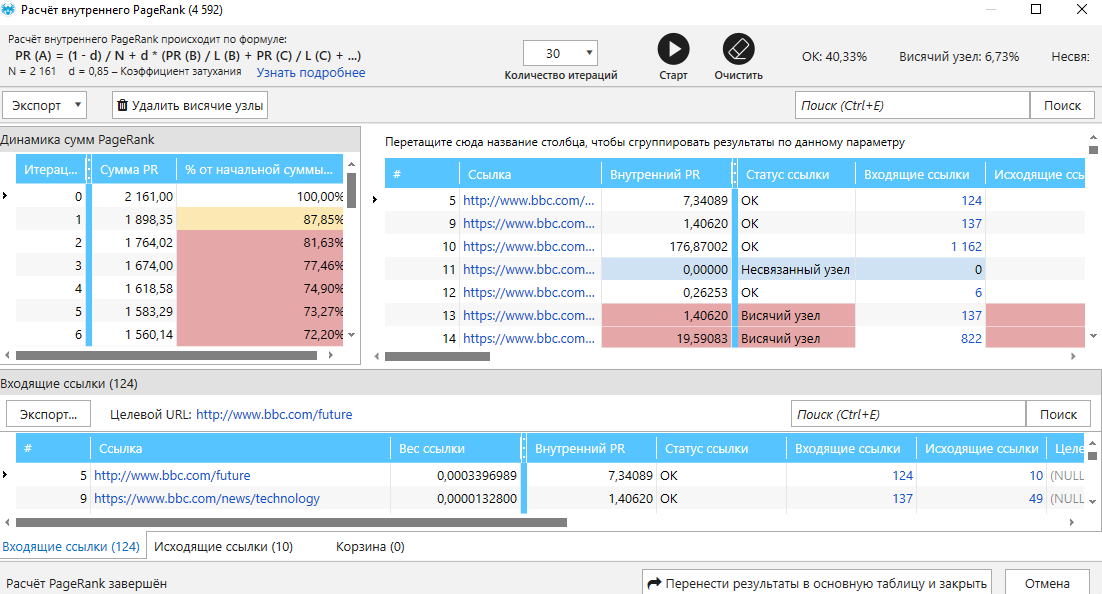

Расчёт внутреннего PageRank

Это инструмент рассчитывает и показывает, как распределяется ссылочный вес по сайту. С его помощью можно узнать, какие страницы получают слишком много или мало ссылочного веса.

Также инструмент позволяет моделировать изменения PageRank страниц при изменении структуры и определять страницы без входящих внутренних ссылок.

Валидатор XML Sitemap

Инструмент проверяет карту сайта на различные ошибки, которые основаны на официальной документации Standart Sitemap Protocol.

Также в «Валидаторе» есть возможность отправлять ping поисковым системам, если требуется сообщить поисковым системам об изменениях в файле Sitemap.

Окно инструмента очень похоже на основное окно программы не только визуально, но также функциями фильтрации, экспорта и сохранения URL.

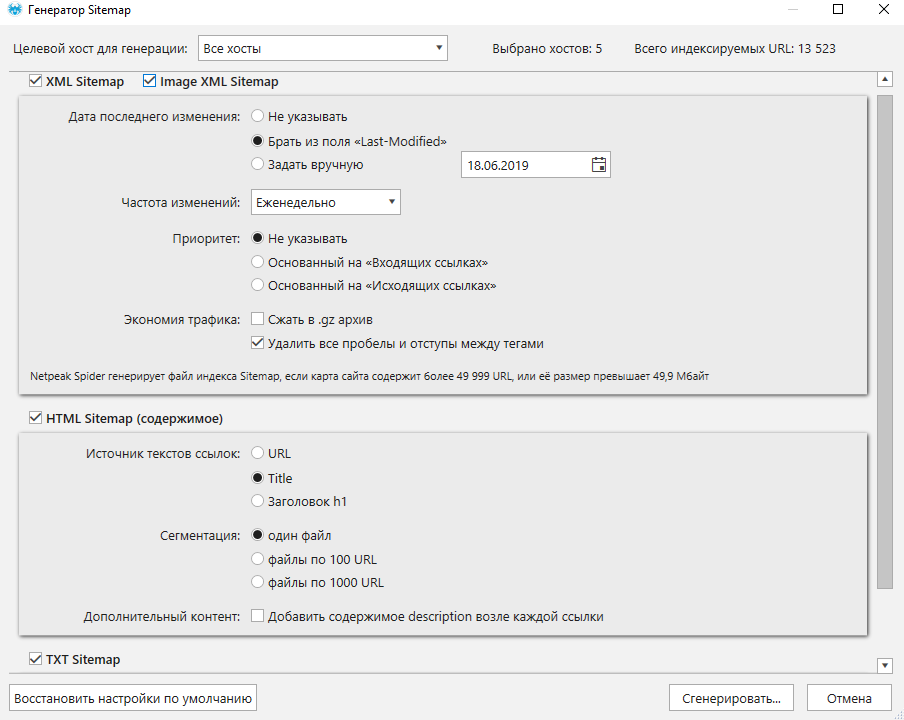

Генератор Sitemap

Инструмент генерирует карту сайта в формате XML, Image, HTML и TXT. Прежде чем сгенерировать любой из видов карты сайта, инструмент предложит вам выбрать параметры и настройки в соответствии с вашими требованиями.

Сохранение проекта и результатов

После окончания работы в программе и инструментах, вы можете сохранить полученные данные как на свой компьютер, так и сам проект, который можете открыть в том же виде в любой момент.

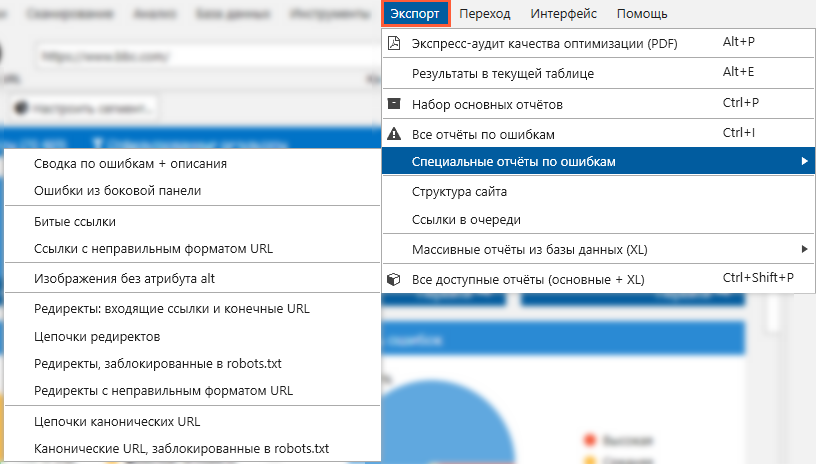

Скачать отчёты и результаты сканирования позволяет меню «Экспорт», которое доступно как в основном окне программы, так и в дополнительных окнах, а также окнах встроенных инструментов.

Есть возможность экспорта всех результатов, результатов в текущей таблице и отдельные виды отчётов:

Экспортированные отчёты форматов .CSV и .XLSX напоминают таблицу самой программы: здесь отображены столбцы с URL и параметрами, а также сохраняется цвет ячеек в соответствии с критичностью ошибки.

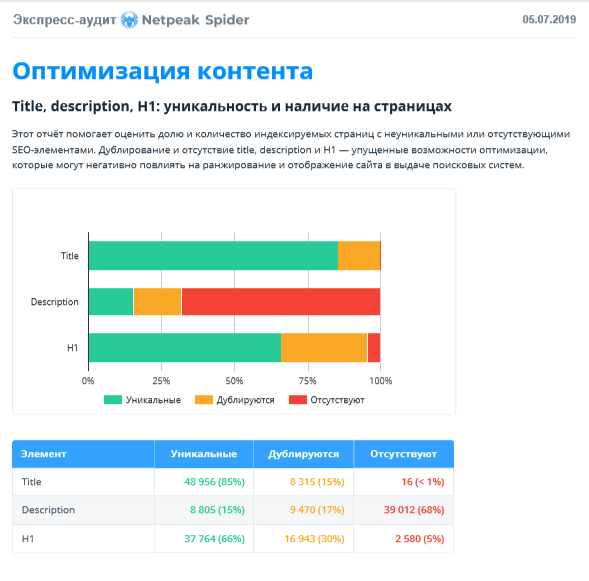

Через меню «Экспорт» есть возможность одним кликом скачать отчёт с экспресс-аудитом качества оптимизации в формате PDF.

Зачем нужен этот отчёт? Он наглядно показывает ключевую информацию и визуализирует её, что облегчает восприятие и дальнейшую работу с результатами аудита.

Теперь предлагаю разобраться с тем, как работать с проектами в самой программе.

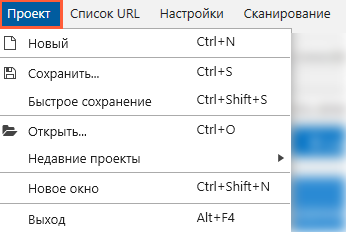

Меню «Проект»

Сохранение и открытие выполняется с помощью меню «Проект». Если проект необходимо сохранить в определённой папке и дать ему название, выбирайте пункт «Сохранить». Если проект нужно сохранить с автоматически сгенерированным именем в папку, которая выбрана по умолчанию, воспользуйтесь кнопкой «Быстрое сохранение».

Проект можно сохранять и незавершённым: например, когда аудит нужно отложить на потом, вы можете прервать сканирование вручную, сохранить проект, а затем в удобное время открыть и продолжить сканирование кнопкой «Старт».

Кстати, в программе предусмотрена мультиоконность: если вам нужно выполнять SEO-аудит одновременно двух сайтов, открывайте новое окно с помощью этого же меню и можете смело приступать к работе.

Чем Netpeak Spider лучше Screaming Frog SEO Spider

Подводя итоги, хочется отметить, что Netpeak Spider отлично справляется с техническим аудитом сайта, имеет интуитивно понятный интерфейс и много полезных фишек, которые вы не найдёте в других краулерах, в том числе и Screaming Frog SEO Spider. Так как этот вопрос задают многие SEO-специалисты, предлагаю сразу его рассмотреть.

Netpeak Spider обладает следующими преимуществами:

— потребляет значительно меньше оперативной памяти;

— определяет в два раза больше ошибок и позволяет их фильтровать в один клик;

— есть возможность легко настраивать и управлять параметрами сканирования в соответствии с потребностями пользователя;

— обладает уникальной функцией сегментации, которая изменяет отображение результатов во всей программе;

— имеет адаптивный дашборд, с помощью которого можно наблюдать за процессом сканирования и, а после сканирования — работать с диаграммами и графиками по ключевым параметрам;

— даёт глубокий анализ структуры сайта;

— проводит валидацию XML Sitemap;

— позволяет экспортировать отчёты с аудитом качества оптимизации в формате PDF;

— показывает специальные статус-коды.

И это только самые основные! Если брать в расчёт все фичи, их получится больше 40.

Кстати дополнительными преимуществами также считаю русскоязычный интерфейс программы и оперативную поддержку пользователей — при знакомстве с новой программой это особенно важно.

Перечень всех задач, которые решает Netpeak Spider, также не мал, но я выделю базовые.

Что можно делать в NS:

— проводить технический SEO-аудит сайта и проверять его на более чем 50 важных параметров;

— делать глубокую SEO-аналитику;

— настраивать кастомный парсинг для сбора различной информации с сайтов, которую можно использовать для анализа, проведения исследований и т.д;

— получать полную структуру сайта;

— улучшать перелинковку с помощью информации о внутреннем PageRank страниц сайта;

— генерировать и проверять разные типы карты сайта;

— делать экспресс-аудит сайта клиента.

И напоследок: если вы заинтересовались инструментом и хотите сначала его протестировать, просто зарегистрируйтесь и пользуйтесь бесплатной версией программы. Скачивайте Нетпик Спайдер и занимайтесь анализом сайта с полным функционалом!

А если вам понравится, то по ПРОМО-КОДУ 7747a03d вы можете получить скидку 25% при первой покупке доступа к Netpeak Spider.

Регистрируйтесь тут, чтобы получить доступ к бесплатной версии программы (банковская карта не нужна).